[市場動向]

富士通研究所、顔の映像から人の集中度を定量化できるAIモデルを開発、0.0~1.0で数値化

2021年3月1日(月)日川 佳三(IT Leaders編集部)

富士通研究所は2021年3月1日、顔の映像から人の集中度を定量化する“集中度推定AIモデル”を開発したと発表した。表情筋の動きの変化から、集中時と非集中時の顔面の状態の違いを検出する。従来と異なり、文化的背景の影響を受けにくいとしている。AIモデルを検証したところ、85%を超える精度で集中度を定量的に推定できることを確認したとしている。

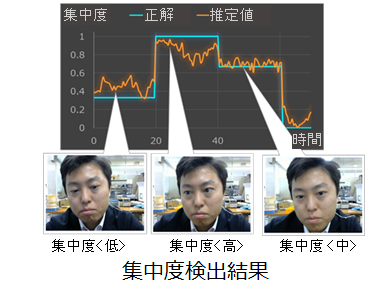

富士通研究所は、顔の映像から人の集中度を定量化する“集中度推定AIモデル”を開発した。集中と非集中の状態を、0.0(非集中)~1.0(集中度最高)の数値で定量的に示すことができる(図1)。

図1:集中度の推定結果の例(出典:富士通研究所)

図1:集中度の推定結果の例(出典:富士通研究所) e-learningでの集中度や、デスクワークへの没入状態、工場の組み立て作業の集中度合いなど、様々なタスクにおいて、集中度の推定に利用できる。

富士通研究所は、AIモデルの有効性を検証した。学習に利用した日本、米国、中国の被験者の集中度を推定したところ、85%を超える精度で集中度を定量的に推定できることを確認した。

富士通研究所は、今回のAIモデルが学習していない異なるタスクにも適用できることを確認。ドライブシミュレータ映像で推定したところ、「NEDO眠気指標」に基づいてラベル付けした正解データに対して高い相関を示したという。眠気による集中度低下を推定できていることを確認した。

表情筋の変化を利用し、文化的背景の影響を受けにくく

今回開発した手法は、表情筋の動きの変化から、集中時と非集中時の顔面の状態の違いを検出するというもの。この手法の特徴として同社は、従事するタスクや、人が育った文化的背景の影響を受けにくいことを挙げる。

「従来、集中度を定量化するAIモデルを作成する場合、e-learningなど特定のタスクを実行している人の表情やふるまいを学習することによって作成していた。しかし、表情やふるまいは、従事するタスクや人が育った文化的背景によって異なる。このため、作成したAIモデルは、個別のモデルにならざるを得なかった」(同社)。

表情筋の変化を高精度で検出する独自技術を開発

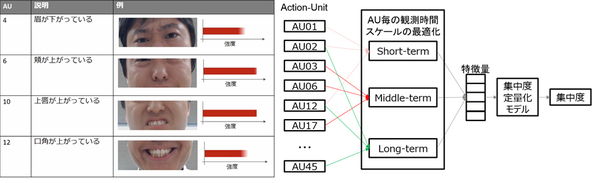

人が集中してタスクを実行しているときは、顔が強張る、目を凝らすなど顔面の状態に微小な変化が生じる。「これらの変化は、人類共通に適用できる概念として提唱されているAction Unitを活用することで、原理的にはふるまいや文化的背景の違いによらず検出できる」(同社)。

しかし、集中時と非集中時の微小な顔面状態の違いをカメラで撮影した顔の動画データから捉えようとすると課題があるという。「例えば、Action Unitの動きで出来たしわと、年齢によるしわとの区別が必要になる。Action Unit自体の精度の向上が課題となる」(同社)。

今回、富士通研究所は、Action Unitを高精度で検出する独自の技術を開発した。表情筋の動きの強さが異なるペア画像を学習させる方式である。これにより、表情筋の相対的な変化を的確に学習させる。

口元に力が入るといった数秒程度の短期間の変化や、目を凝らして一心不乱に見つめるなど数十秒にわたる長期間の変化を、Action Unitごとに定義した時間単位で捉える。これにより、文化的背景に依存しないAIモデルを開発した(図2)。

図2:集中状態に現れる人共通の特徴抽出による集中度推定方式(出典:富士通研究所)

図2:集中状態に現れる人共通の特徴抽出による集中度推定方式(出典:富士通研究所)拡大画像表示

さらに、人の集中状態の教師データの収集にあたっては、タスク固有のふるまいが生じないように設計した作業を、日本、米国、中国の延べ650人で実施した。こうして得たデータセットを用いて学習させることにより、特定のタスクに依存しない、汎用的な集中度推定AIモデルを作成した。

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-