2023年のビジネストレンドで最も注目された生成AI。これまで手間と時間をかけて行っていた業務の支援・代行に期待がかかる一方、特有のリスクなど自社業務への適用には注意すべき点も多い。企業はこの破壊的なテクノロジーをどう捉え、何に注意すべきか。四半世紀以上AIの進化を追ってきたデル・テクノロジーズの増月孝信氏に話を聞いた。

「それって本当に生成AIじゃなきゃダメ?」

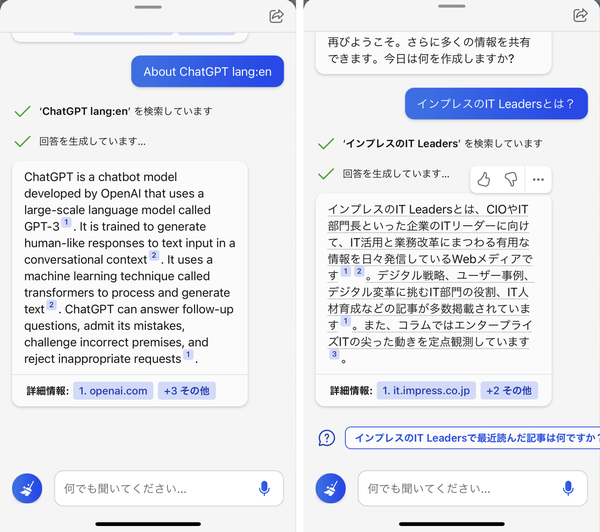

2022年11月30日、米OpenAIが対話型/チャットサービス「ChatGPT」(画面1)を公開して以降本格化し、2023年を通じて大ブームとなった生成AI。その破壊的なインパクトから、企業・組織で導入ないしテスト導入に取り組む動きが活発化している。

画面1:「ChatGPT」をきっかけに、生成AIは2023年を通じて大ブームとなった

画面1:「ChatGPT」をきっかけに、生成AIは2023年を通じて大ブームとなった拡大画像表示

企業での導入方法として、マイクロソフトの「Azure OpenAI Service」やAWSの「Amazon Bedrock」といったマネージド型の生成AIサービスの契約、既存の大規模言語モデル(LLM)へのカスタマイズ、そしてLLM/基盤モデルの自社構築などがある。だが、AIの進化を長年にわたって追ってきたデル・テクノロジーズの増月孝信氏(写真1)は、「どの生成AI(サービス)を導入するのか」の以前に、「そもそも、なぜ生成AIを導入するのか」を熟考する必要があると指摘する。

写真1:デル・テクノロジーズ DCWソリューション本部シニア・ビジネス開発マネージャー兼AI Specialist/CTO Ambassadorの増月孝信氏

写真1:デル・テクノロジーズ DCWソリューション本部シニア・ビジネス開発マネージャー兼AI Specialist/CTO Ambassadorの増月孝信氏「まず大前提として考えるべきは、『生成AIを導入する業務が、事業として差別化ポイントになっているか』です。生成AIありきではなく、生成AIの導入でどのような付加価値を生み出し、それをビジネスモデルとして確立するというビジョンを明確化する必要があります。例えば、人事部門の業務を効率化したいのであれば、専用のパッケージやSaaSで実現できるケースがほとんどです。莫大な投資をして生成AIを活用する仕組みを開発する必要はないのです」(同氏)

自社のビジョンや戦略が曖昧では、生成AI導入のロードマップは作成できない。そうした状態を放置したまま、スモールスタートで「導入しやすいところから」生成AIの検証にかかっても、終わりのないPoC(概念実証)に陥ってしまうというわけだ。

まずは現在の業務内容、フローを棚卸しし、目指す将来の姿に向けて業務改善ポイントや新規事業のビジネスモデルを検討すること、と増月氏。そして、「将来、当社には生成AIが必要だ」という結論を出してから、導入の段階的な計画立案と必要なリソースを定義するという順序になる。ここからようやく「どの生成AIを導入するか」を検討するフェーズに入ることになる(図1)。

図1:生成AI導入のフェーズ(出典:デル・テクノロジーズ)

図1:生成AI導入のフェーズ(出典:デル・テクノロジーズ)拡大画像表示

技術の特性の違いを押さえる

増月氏は、「現在、多くの企業は事前学習済みのLLM/基盤モデルの利用からスタートしていますが、導入する生成AIがどのようなデータで学習し、どのモデルを採用しているか把握することが大切です」と指摘する。

例として、文書作成や要約、翻訳などを担う自然言語処理(NLP)のエンコーダ/デコーダモデルを挙げる。NLPでは、テキストや画像などの入力データを理解しやすい形式に変換するエンコーダと、それを出力データにするデコーダを組み合わせている。

増月氏は、「ChatGPTはエンコーダ/デコーダモデルではなくデコーダしか使いません。そのため、文脈理解や情報統合といった能力には限界があります。こうした特性を理解しないで導入を決めてしまうと、期待どおりの効果は得られないでしょう」と説明する。

また、「どのようなデータに基づいて学習しているか」も重要な着眼点だという。例えば、ChatGPTのLLMであるGPTは、膨大なインターネット上の情報を学習データとし、パラメータ数はGPT-3で1750億とされている。一方、金融情報サービスの米ブルームバーグが独自構築したLLM「BloombergGPT」は500億パラメータながら、その学習元は金融機関向けに特化している。

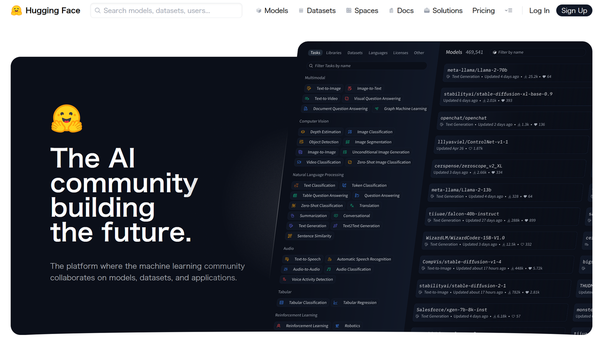

増月氏は、多くの事前学習済みのLLM/基盤モデルをライブラリ化し、オープンソースで提供している米Hugging Face(ハギングフェイス、画面2)を挙げ、その中から自社の用途にあったものを利用するのも一策であると助言する。

画面2:Hugging FaceはLLM/基盤モデルをライブラリ化して公開している

画面2:Hugging FaceはLLM/基盤モデルをライブラリ化して公開している拡大画像表示

AIバイアスのチェックには“セカンドオピニオン”も

一方、生成AIの基盤モデルを自社で構築する選択をした企業にとって重要となるのがデータアセスメントだという。モデルの性能は元になるデータに大きく依存する。そのため、データの質・量の確保やデータの適合性の確認、クレンジングといった作業が必要になる。「特に、データの利用が法規制や倫理的基準に準拠しているか、個人情報が包含されていないかといったガバナンスの部分は、細心の注意を払わなければなりません」(増月氏)。

増月氏は、さらにAI特有のバイアスの問題も考慮する必要があると指摘する。偏った学習データを利用しないことはもちろん、モデルのアーキテクチャや学習方法によってもバイアスが生じる可能性がある。バイアスの発生は特定分野のデータ特性やパターンを過度に重視することが原因になるとし、こうした事態を避けるためには異なるモデルからの出力を比較し、整合性を取るといった作業が必要になると説明。「例えるなら、医療分野におけるセカンドオピニオンのアプローチです」と述べ、以下のように解説する。

「モデルのバイアスやデータガバナンスの問題は、個々のデータに起因することが多いです。例えば数PB(ペタバイト)のデータをネットから収集しても、実際に学習データとして利用できるのはわずか1~3%程度。時間とコストをかけてデータを集めても、アセスメントをなおざりにすると、生成されたモデルが使い物になりません。事前学習済みモデルであれ、独自開発モデルであれ、運用開始後は常にアウトプットをモニタリングし、継続してモデルの改善を実施する必要があります」(増月氏)

「運用に伴ってモデルの精度は変化します。ですからアジャイル開発のように継続したチューニングが求められるし、場合によっては再学習させなければなりません」と増月氏。そうした仕組み作りや役割分担は組織全体で考える必要があるが、その部分が手薄になってしまうケースも少なくないという。実際、社内で独自モデルを構築したものの、実際に運用する現場IT担当者に技術移管できず、頓挫するケースもある、と同氏は警告する。

●Next:生成AI利用で重要なITガバナンス/情報セキュリティ管理

会員登録(無料)が必要です

- 1

- 2

- 次へ >

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-