NTTドコモが自社のデータ分析基盤に「Google BigQuery」を導入した。オンプレミスとAWS(Amazon Web Services)で構成していた既存のデータ分析基盤にBigQueryを追加し、2021年7月から本格稼働を開始している。現在、高い処理性能を要求するユースケースなどユーザークエリーの6~7割をBigQueryが捌いている。同年9月7日、グーグル・クラウド・ジャパンが開催した説明会で取り組みを紹介した。

NTTドコモがクラウド活用について、2日にわたって自社の取り組みの詳細を披露している。AWSの運用/コスト最適化の取り組みに続いて(関連記事:NTTドコモが取り組んだAWSコスト削減、必要なリソースを必要な時だけ使用)、今回はデータ分析基盤に「Google BigQuery」を導入した取り組みを紹介した。

NTTドコモは2014年から、社内のデータ分析に向けて「IDAP」(Integrated Data Analytics Platform)と呼ぶ内製のビッグデータ分析基盤を運営している(図1)。

ビッグデータ分析基盤は、オンプレミスとクラウドのハイブリッド構成をとる。データウェアハウス(DWH)は125台の「Amazon Redshift」で開始し、データの増加に応じてシステムを拡張している。現在ではGoogle Cloudとも接続し、Amazon Redshiftに加えてGoogle BigQueryも導入し、分析基盤の強化をはたしている。

図1:NTTドコモが社内のデータ分析者に向けて運営しているデータ分析基盤「IDAP」の経緯(出典:NTTドコモ)

図1:NTTドコモが社内のデータ分析者に向けて運営しているデータ分析基盤「IDAP」の経緯(出典:NTTドコモ)拡大画像表示

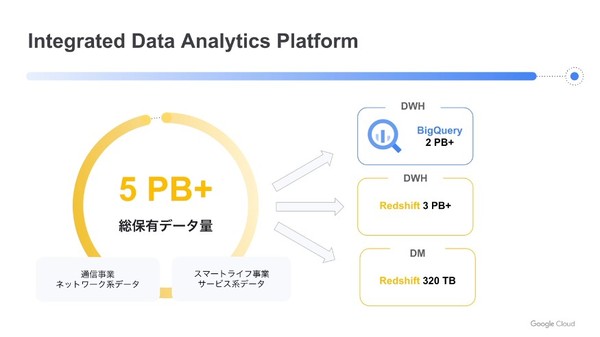

同社でIDAPを利用する分析担当者は2500人に及ぶ。データ加工処理の対象となるデータ量は1日あたり50TB以上。分析者が分析可能な総データ量は5PB以上で、DWHとしてBigQueryに2PB以上、Redshiftに3PB以上を格納している(図2)。分析対象のビッグデータは、通信事業のネットワーク系データやスマートライフ事業のサービス系データだという。

図2:データ分析基盤「IDAP」におけるGoogle BigQueryとAmazon Redshiftの棲み分け(出典:NTTドコモ)

図2:データ分析基盤「IDAP」におけるGoogle BigQueryとAmazon Redshiftの棲み分け(出典:NTTドコモ)拡大画像表示

BigQueryは2020年10月に小規模導入を始め、2021年7月から本格的に利用を開始した。その導入にあたりデータ分析のユースケースを見直したところ、BigQueryに移行することで性能が向上するケースが多かったため、現在ではユーザークエリーの6~7割をBigQueryが捌いている。

以前より同社では、サービスの稼働環境としてAWSの利用が進んでおり、DWHに収集する前のデータソースの多くはAWS上にある。このため、データの収集や加工、およびユーザークエリーの一部(約3割)はAWS上で処理している。「分析したいデータのすべてをBigQueryに転送すると転送コストがかかるので、大規模な読み取りや結合処理など移行によって得られるメリットが大きいユーザークエリーをBigQueryに任せている」(同社)という。

●Next:NTTドコモがBigQueryを導入したきっかけと評価、導入効果は?

会員登録(無料)が必要です

- 1

- 2

- 次へ >

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-