[市場動向]

サーバーレスでスケールを確保する分散DB、LLMを活用した開発環境など─AWS re:Inventでの主な発表

2023年12月6日(水)IT Leaders編集部、日川 佳三

アマゾン ウェブ サービス ジャパン(AWSジャパン)は2023年12月6日、米AWSが2023年11月27日~12月1日に開催した年次プライベートイベント「AWS re:Invent 2023」の発表内容を紹介した。主なトピックに、データベースのサーバーレス化によるスケーラビリティの確保、高速なストレージとサーバーインスタンス、大規模言語モデル(LLM)を活用したアプリケーション開発環境の整備などがある。

米Amazon Web Services(AWS)は2023年11月27日~12月1日の会期で年次プライベートイベント「AWS re:Invent 2023」を開催した。AWSジャパンは同年12月6日の説明会で、同イベントでの主な発表内容を紹介した。

DBをサーバーレス化してスケーラビリティを確保

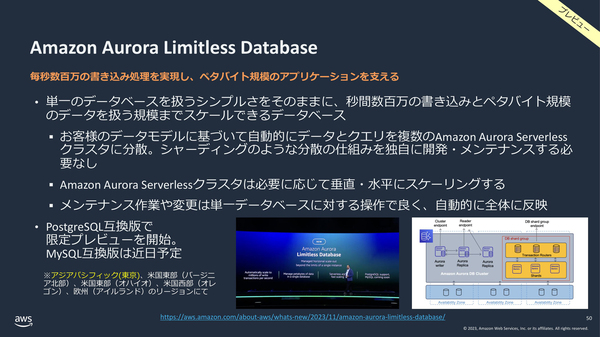

トピックの1つが、データベースのサーバーレス化によるスケーラビリティの確保である。分散データベース「Amazon Aurora Limitless Database」の限定プレビュー版の提供を開始した。データとクエリーを複数のAmazon Aurora Serverlessクラスタに自動で分散する仕組みを備えており、アプリケーションからは単一のデータベースサーバーのように扱える(図1)。

図1:、分散データベース「Amazon Aurora Limitless Database」の概要(出典:アマゾン ウェブ サービス ジャパン)

図1:、分散データベース「Amazon Aurora Limitless Database」の概要(出典:アマゾン ウェブ サービス ジャパン)拡大画像表示

性能については、「秒間数百万の書き込みとペタバイト規模のデータ規模までスケールできる」(同社)としている。ノードを増やす水平方向のスケーリングに加えて、個々のサーバーリソースを拡張する垂直方向のスケーリングに対応するようにした。

サーバーリソースを拡張する仕組みとして、データベース用に開発した独自のサーバー仮想化ミドルウェア「Caspian」を用いる。割り当て済みのリソースを超えるリソースをあらかじめ仮想的に割り当てておき、必要に応じて実際のリソースを動的に割り当てる。

「Amazon Aurora」ではPostgreSQLとMySQLの両互換版が利用できるが、「Amazon Aurora Limitless Database」においてはまず、PostgreSQL互換版のプレビューを東京リージョンを含む各リージョンから提供。MySQL互換版は近日中のプレビューを予定している。

DBキャッシュやDWHをサーバーレス化

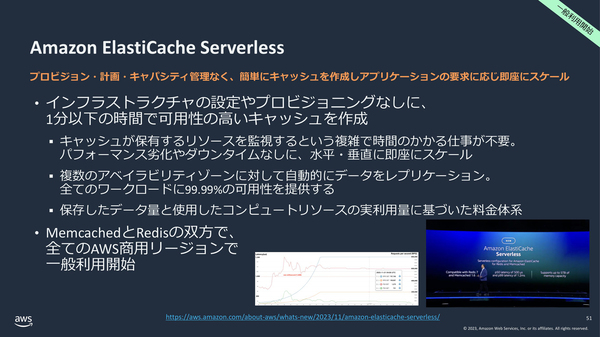

インメモリー型データベースキャッシュをサーバーレス化し、「Amazon ElastiCache Serverless」として一般提供を開始した。キャパシティプランニング(容量設計)などが不要で、1分以内にキャッシュサーバーを構築できる。自動でリソースの使用状況を監視し、データベースと同様に水平・垂直方向にリソースをスケールさせる。キャッシュサーバーのミドルウェアとして、MencachedとRedisを利用可能である(図2)。

図2:インメモリー型データベースキャッシュ「Amazon ElastiCache Serverless」の概要(出典:アマゾン ウェブ サービス ジャパン)

図2:インメモリー型データベースキャッシュ「Amazon ElastiCache Serverless」の概要(出典:アマゾン ウェブ サービス ジャパン)拡大画像表示

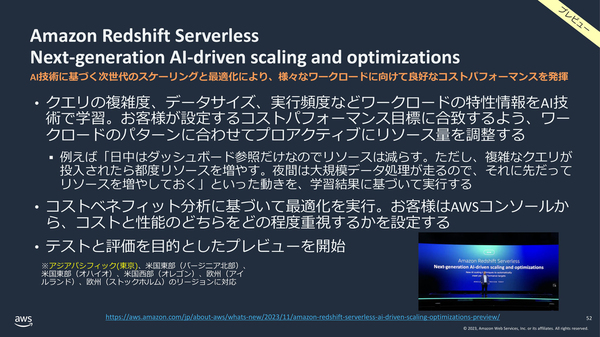

また、データウェアハウス(DWH)をサーバーレス化した「Amazon Redshift Serverless Next-generation AI-driven scaling and optimizations」を、テスト・評価を目的にプレビュー公開を開始した。クエリーの特性をAIが学習し、コストや性能の重視度合いに応じてリソースを自動で調整する(図3)。

図3:サーバーレス化したDWH「Amazon Redshift Serverless Next-generation AI-driven scaling and optimizations」の概要(出典:アマゾン ウェブ サービス ジャパン)

図3:サーバーレス化したDWH「Amazon Redshift Serverless Next-generation AI-driven scaling and optimizations」の概要(出典:アマゾン ウェブ サービス ジャパン)拡大画像表示

例えば、「日中はダッシュボード参照のみなのでリソースを減らすが、複雑なクエリーが投入されたら、つどリソースを増やす。夜間は大規模データ処理を行うので事前にリソースを増やしておく」といった設定をAIの学習結果に基づいて自動実行する。

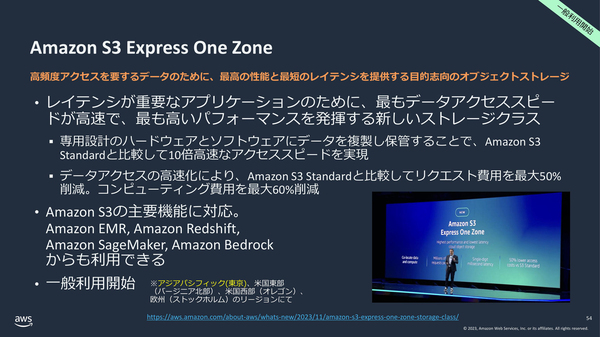

S3ストレージやEC2インスタンスを高速化

オブジェクトストレージ「Amazon S3」においては、これまでよりも低レイテンシで高速なストレージクラスとして「Amazon S3 Express One Zone」の一般提供を開始した。専用設計のハードウェアとソフトウェアにより、標準のAmazon S3と比べてアクセス速度が10倍高速になったという。リクエストの費用が最大で50%、コンピューティングの費用が最大で60%削減されるとしている(図4)。

図4:これまでよりも低レイテンシで高速なS3ストレージ「Amazon S3 Express One Zone」の概要(出典:アマゾン ウェブ サービス ジャパン)

図4:これまでよりも低レイテンシで高速なS3ストレージ「Amazon S3 Express One Zone」の概要(出典:アマゾン ウェブ サービス ジャパン)拡大画像表示

ARMプロセッサの新版「AWS Graviton 4」および同CPUを用いたインスタンス「Amazon EC2 R8gインスタンス」のプレビューを開始した。Graviton 4は、Graviton 3と比べて処理性能が30%向上し、コア数が50%多く、メモリー帯域が75%高速になった。R8gインスタンスは、R7gインスタンスと比べて3倍のvCPUとメモリー容量を提供する(図5)。

図5:ARMプロセッサの最新版「AWS Graviton 4」と、これを使ったインスタンス「Amazon EC2 R8gインスタンス」の概要(出典:アマゾン ウェブ サービス ジャパン)

図5:ARMプロセッサの最新版「AWS Graviton 4」と、これを使ったインスタンス「Amazon EC2 R8gインスタンス」の概要(出典:アマゾン ウェブ サービス ジャパン)拡大画像表示

また、AIの基盤(ファウンデーション)モデルと大規模言語モデル(LLM)のトレーニング(学習)を高速化するアクセラレータチップの新版「AWS Trainium 2」を発表した。現行のTrainiumと比べて学習処理が4倍高速になり、メモリー容量は3倍に増えた。エネルギー消費効率は最大で2倍に向上した(図6)。

図6:AIアクセラレータ新版「AWS Trainium 2」の概要(出典:アマゾン ウェブ サービス ジャパン)

図6:AIアクセラレータ新版「AWS Trainium 2」の概要(出典:アマゾン ウェブ サービス ジャパン)拡大画像表示

クラスタ化により、最大10万個のTrainium 2チップで65EFLOPS(エクサフロップス)の処理能力を発揮する。3000億パラメータのLLMの学習に要する期間を、数カ月から数週間の単位に短縮可能だとしている。

●Next:生成AIを活用するための機能群

会員登録(無料)が必要です

- 1

- 2

- 次へ >

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-