[市場動向]

楽天、大規模言語モデル「Rakuten AI 2.0」と小規模言語モデル「Rakuten AI 2.0 mini」をOSSとして提供

2025年2月13日(木)日川 佳三(IT Leaders編集部)

楽天グループは2025年2月12日、大規模言語モデル「Rakuten AI 2.0」と小規模言語モデル「Rakuten AI 2.0 mini」を提供開始した。いずれも2024年12月に発表済みのモデルであり、複数のサブモデルで構成したMixture of Experts(MoE)アーキテクチャを採用している。今回、これらの基盤モデルと、インストラクションチューニング済みモデルの提供を開始した。いずれもApache 2.0ライセンスを採用したOSSであり、Hugging Faceからダウンロードできる。

楽天グループの「Rakuten AI 2.0」は大規模言語モデル(LLM)、「Rakuten AI 2.0 mini」は小規模言語モデル(SLM)である。基盤モデルとインストラクションチューニング済みモデル(プロンプトへの指示とアウトプットのデータセットでファインチューニングしたモデル)を用意した。全モデルはApache 2.0ライセンスを採用したOSS(オープンソースソフトウェア)であり、Hugging Faceからダウンロードできる。

特徴の1つは、複数のサブモデル(エキスパート)で構成するMixture of Experts(MoE)アーキテクチャを採用したこと。推論や学習において、その場面で最も適したエキスパートのサブセットだけをアクティブ化して入力データを処理する仕組みである。これにより、汎用的で高度な推論を行えるとしている。

LLMのRakuten AI 2.0は、2024年3月に公開した「Rakuten AI 7B」を基に開発した、8x7BのMoEモデルである。8つの70億パラメータで構築したサブモデルで構成する。一方、SLMのRakuten AI 2.0 miniは、15億パラメータの小規模モデルである。いずれも日本語と英語のデータを用いて学習している。

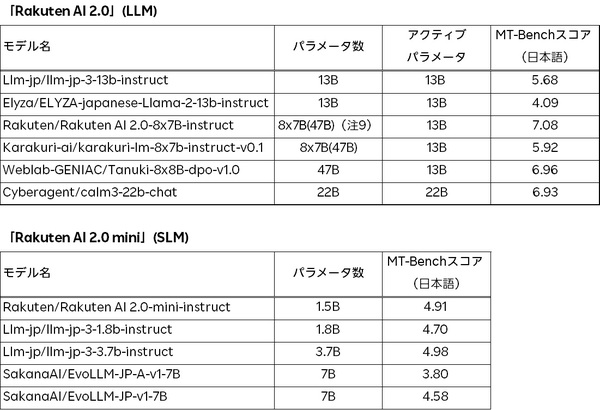

楽天は、会話形式や指示形式のデータを使って基盤モデルをファインチューニングした後、ベンチマーク「日本語版MT-Bench」を使って性能を評価した。Rakuten AI 2.0のインストラクションチューニング済みモデル、Rakuten AI 2.0 miniのインストラクションチューニング済みモデル、および他の国産モデルとの比較スコアは、表1の通りである。

表1:LLM「Rakuten AI 2.0」とSLM「Rakuten AI 2.0 mini」のベンチマーク値(出典:楽天グループ)

表1:LLM「Rakuten AI 2.0」とSLM「Rakuten AI 2.0 mini」のベンチマーク値(出典:楽天グループ)拡大画像表示

日本語版MT-Benchの値を見ると、Rakuten AI 2.0インストラクションチューニング済みモデルは、同程度のアクティブパラメータ数を持つ他のモデルと比べて性能が高い。同様に、Rakuten AI 2.0 miniインストラクションチューニング済みモデルも、同様のサイズのモデルと比べて性能が高い。

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-