NECは2019年8月19日、ディープラーニングに必要な学習データ量を半減させられる技術を開発したと発表した。少ない学習データ量でも識別精度を高められるとしている。ニューラルネットワークの中間層で得られる特徴量を意図的に変化させることで、識別が難しい学習データを集中的に人工生成する仕組み。

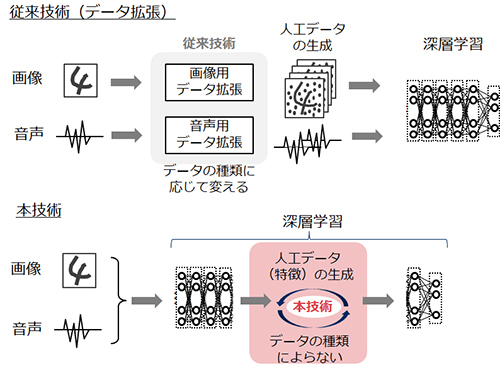

NECは今回、ディープラーニングに必要な学習データ量を半分程度に削減できる技術を開発した(図1)。データの種類を問わず、汎用的に適用できるという。これまで学習データの収集時間などが阻害要因となっていた、製品の外観検査やインフラ保全などのシステムを、早期に立ち上げられるようになる。

図1:従来技術(学習前のデータの拡張)と今回開発した技術(ニューラルネットワークの中間層で得られる特徴量を変化させる)の違い(出典:NEC)

図1:従来技術(学習前のデータの拡張)と今回開発した技術(ニューラルネットワークの中間層で得られる特徴量を変化させる)の違い(出典:NEC) ディープラーニングにおいて識別精度を高めるためには、識別が難しい学習データをより多く学習する必要がある。このためには、学習に適した質の良いデータを十分に確保することが重要となる。一方で、例えば、外観検査における不良品データの収集や、不良品を模擬したデータの作成には、多大な時間やコストがかかってしまう。

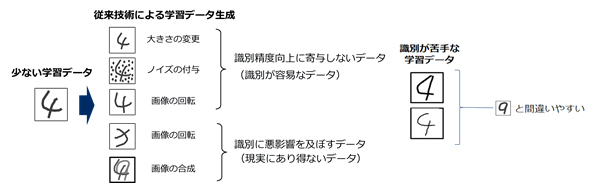

識別精度を高めるためには、識別が難しい「苦手な学習データ」をより多く学習することが有効である。学習データを人工的に生成する手法として従来は、データ拡張と呼ばれる手法を用いていた。ニューラルネットワークに入力する前にデータを意図的に加工・変形させ、学習データ量を人工的に増やしていた。

しかし、データ拡張のようなデータの増やし方では、「苦手な学習データ」の量が不十分で、なおかつ識別精度の向上に寄与しないデータも多く生成されてしまうため、十分な学習効果が得られなかった(図2)。

図2:従来技術では、識別が苦手な学習データを生成することが難しかった(文字認識の場合の概念図)(出典:NEC)

図2:従来技術では、識別が苦手な学習データを生成することが難しかった(文字認識の場合の概念図)(出典:NEC) 今回開発した技術は、ニューラルネットワークの中間層で得られる特徴量を意図的に変化させる。識別が失敗しやすい「苦手な学習データ」を集中的に人工生成できるので、識別精度が高まる。NECでは、本技術を公開データベース(手書き数字認識:MNIST、物体認識:CIFAR-10)で評価し、学習データ量が半分でも従来技術と精度が変わらないことを確認した。

また、従来手法であるデータ拡張の場合、データの種類ごとにデータの生成方法を変える必要があった。例えば、画像では大きさや回転角度など、音声では声の高さや話す速さなどを変えることで、データを人工的に増やしていた。さらに、専門家がデータ生成方法を選び、学習に悪影響を及ぼすデータが発生しないよう調整する必要があった。

今回開発した技術は、ニューラルネットワーク内部の数値に基づいて自動的に学習データを生成することから、多様なデータに対して汎用的に適用できる。専門家による調整が要らない。

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-