NRIセキュアテクノロジーズは2023年12月18日、セキュリティ診断サービス「AI Red Team」を提供開始した。同社の専門家が実際のシステムに擬似攻撃を行い、生成AI/LLM(大規模言語モデル)を利用するシステム/サービスが抱えるAI固有の脆弱性や、連携する周辺機能を含めたシステム全体の問題点を診断・評価する。

NRIセキュアテクノロジーズの「AI Red Team」は、生成AI/LLM(大規模言語モデル)を利用するシステム/サービスを対象としたセキュリティ診断サービスである。同社の専門家が実際のシステムに擬似攻撃を行い、生成AIを利用するシステムが抱えるAI固有の脆弱性や、連携する周辺機能を含めたシステム全体の問題点を診断・評価する(図1)。

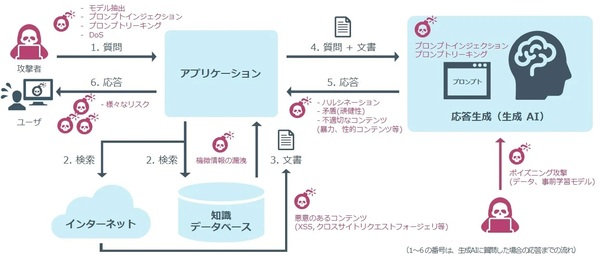

生成AI/LLMを利用するシステムが抱えるリスクの例(出典:NRIセキュアテクノロジーズ)

生成AI/LLMを利用するシステムが抱えるリスクの例(出典:NRIセキュアテクノロジーズ)拡大画像表示

「AI技術自体がサービスとして機能することはなく、周辺の機能などと連携することで具体的なサービスを構成する。AI Red Teamは、LLM単体でのリスクを洗い出した後、LLMを含むシステム全体のリスクを評価する」(同社)としている。この2段階の診断から、見つかった問題点とリスク低減策をまとめたレポートを提供する。

NRIセキュアはサービス提供の背景として、生成AI/LLMの利用が拡大する一方で、プロンプトインジェクション(入力プロンプトを操作して予期しない/不適切な情報を取得する攻撃)やプロンプトリーキング(入力プロンプトを操作して、LLMに元々設定されていたコマンドや機密情報を盗み出す攻撃)など、特有のリスクや脆弱性が存在することを挙げる。「さらに、LLMの利用にあたっては、ハルシネーション、機微情報の漏洩、不適切なコンテンツの生成、バイアス問題といったリスクが存在する」(同社)。

調査で実際のリスクを評価して対策案を提示

AI Red Teamの主な特徴として以下の2点を挙げている。

(1)LLM向けのDAST(実行中のアプリケーションをテストし、脆弱性を動的に評価する手法)を採用し、自動でテストする診断用ツールを開発した。効率的かつ網羅的に脆弱性を検出する。

そのうえで、生成AI/LLMのセキュリティに精通したNRIセキュアのエンジニアが診断を行い、自動テストではカバーできないシステム固有の問題点を洗い出す。自動検出した脆弱性をマニュアルの調査によって深く掘り下げるとしている。

(2)システム/サービス全体を診断したうえで、AIに起因する脆弱性が顕在化するかを診断する。AI固有の問題を評価するだけでは対処が難しい「OWASP Top10 for LLM」(LLMの10大セキュリティリスク)にも対処するとしている。

仮にAI自体に脆弱性があり、その対応が困難な場合、システム全体から見た実際のリスクレベルを評価して代替の対策案を提示する。これにより、対策に要するコストの抑制が可能としている。

なお、同社ではAI Red Teamと対をなすサービスとして、AIアプリケーションを定期的に監視する「AI Blue Team」を開発している。2024年4月の提供開始を予定しており、現在、PoC(概念検証)に参加する企業を募集している。

NRIセキュアテクノロジーズ / レッドチーム / 生成AI / 大規模言語モデル / 脆弱性診断 / ペネトレーションテスト / ハルシネーション

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-