Dataiku Japanは2024年10月23日、大規模言語モデル(LLM)のガードレール機能「Dataiku LLMガード」を提供開始した。任意のLLMへのアクセスを仲介するゲートウェイ「Dataiku LLMメッシュ」の機能として、コストガード(利用コスト監視)、安全性ガード(情報漏洩防止)、クオリティーガード(レスポンス品質保証)の3つを提供する。

米Dataiku(データイク)日本法人のDataiku Japanが提供する「Dataiku LLMガード」は、生成AI/大規模言語モデル(LLM)の“ガードレール”機能である。任意のLLMへのアクセスを仲介する同社のゲートウェイサービス「Dataiku LLMメッシュ」に組み込まれている。

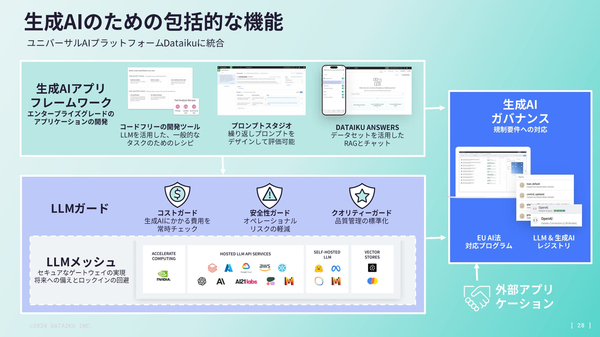

LLMの利用にあたり、(1)コストガード(利用コスト監視)、(2)安全性ガード(情報漏洩防止)、(3)クオリティーガード(レスポンス品質保証)の3つを提供する(図1)。

図1:大規模言語モデル(LLM)のガードレール機能「Dataiku LLMガード」の位置づけ(出典:Dataiku Japan)

図1:大規模言語モデル(LLM)のガードレール機能「Dataiku LLMガード」の位置づけ(出典:Dataiku Japan)拡大画像表示

(1)コストガード

ダッシュボードでLLMの使用状況とコストを可視化する。ユースケース/ユーザーごとにレポートを生成する。LLMの利用ログは社内のユーザー/部門への請求に利用できる。

(2)安全性ガード

個人を特定可能な情報(PII)、有害コンテンツ、禁止用語、プロンプトインジェクションの試みなど、センシティブな情報や悪意のある行為がリクエストやレスポンスに含まれるかを評価する。LLMにリクエストを送信する前に機密情報を編集したり、リクエストをブロックしたり、管理者に警告を発したりするなど情報漏洩防止の適切なアクションがとれる。

(3)クオリティーガード

生成AI固有の品質指標とモデル結果を並べて比較する。LLM監視・評価のための標準化されたツールなどにより、LLMの概念実証(PoC)から本番稼働まで、品質を保証するとしている。

LLMガード機能を提供するLLMメッシュは、任意のLLMへのアクセスを仲介するAPIゲートウェイ。アプリケーションにハードコーディングされたLLMとの依存関係を解消し、アプリケーションとLLM間のリクエストを管理・ルーティングする。また、クエリーに対するレスポンスをキャッシュして再利用する機能も備え、LLMの利用コスト削減に役立てられる。

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-