[市場動向]

NICT、日本語に特化した400億パラメータの大規模言語モデルを試作

2023年7月5日(水)日川 佳三(IT Leaders編集部)

国立研究開発法人情報通信研究機構(NICT)は2023年7月4日、Webから収集した350GBの日本語Webテキストだけを使って、400億パラメータの大規模言語モデルを開発したと発表した。現在、さらに大規模な1790億パラメータの大規模言語モデル(OpenAIのGPT-3と同等規模)を学習中。学習用テキストの大規模化にも取り組んでいる。

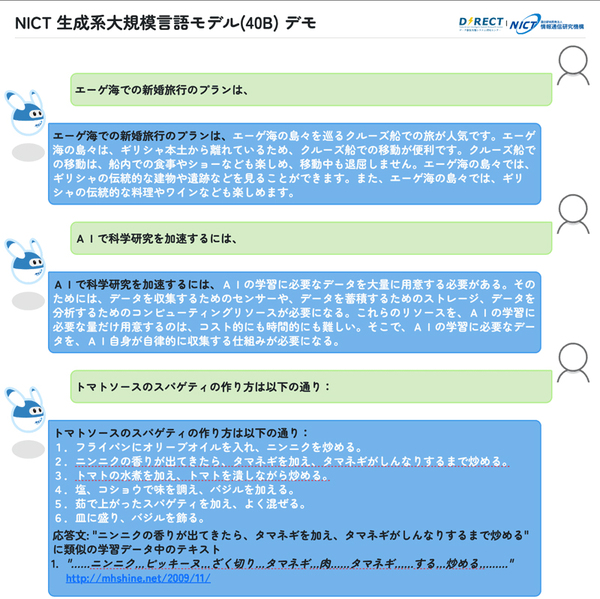

NICTは、Webから収集した350GBの日本語Webテキストだけを使って、400億パラメータの大規模言語モデル(以下、日本語大規模言語モデル)を開発した。日本語でのやり取りが可能な水準に到達しているという(画面1)。現在、さらに大規模な1790億パラメータの大規模言語モデル(OpenAIのGPT-3と同等規模)を学習中である。学習用テキストの大規模化にも取り組んでいる。

図1: NICTの大規模言語モデルプロトタイプの動作例(出典:国立研究開発法人情報通信研究機構)

図1: NICTの大規模言語モデルプロトタイプの動作例(出典:国立研究開発法人情報通信研究機構)拡大画像表示

日本語大規模言語モデルは、ユーザーインタフェースを含め、4カ月程度で開発した。今回は、学習の完了を優先させて事前学習を実施しており、ファインチューニングや強化学習は未実施である。このため、入出力が短いことや日本語表現が洗練されていないことなど性能面ではChatGPTなどと比較できるレベルではない。

用意したユーザーインタフェースでは、入力したテキスト(プロンプト)に対し、その後続のテキストを生成する。「入力を工夫すれば、現在の状態でも、各種のタスクを実施できる可能性がある。一方、事実と異なる内容を含むテキストや、意味をなさないテキストを生成することも確認済み」(NICT)。

著作権侵害を容易にチェックできるように、生成したテキストに類似するテキストが学習データにないかを自動で検索する機能も付けている。

今回の成果は、400億パラメータの日本語大規模言語モデルを試作(事前学習)したというものであり、NICTとしては、事前学習に用いるテキストが十分であるとは考えていない。今後は、学習用のテキストについて、日本語を中心として、さらに大規模化していく。

今後は、人手で作成した大量の学習データ(150万件を超える質問応答用データなど)を活用してファインチューニングなどを実施し、品質を高める。これにより、具体的なアプリケーションで活用しやすくする予定である。

●Next:NICTのAIへの取り組みの経緯

会員登録(無料)が必要です

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-