IoT(Internet of Things:モノのインターネット)が現在、注目キーワードであることは間違いない。だが、それと引き替えに、ビッグデータの分析・活用が、どこかへ行ってしまうとしたら問題だろう。IoTとビッグデータは表裏一体の関係にあり、それはモバイルなども同じ。ITで経営や事業に貢献するにはビッグデータの分析・活用が必須だ。では、ビッグデータの分析・活用にどう取り組めばいいのか−−。こうした問いかけに答えようと、データ専門企業のランドスケープが2015年4月下旬、米Googleのエンジニアを含む著名な専門家を招いて“ビッグデータ分析の今”を伝えるセミナーを開催した。

来日した専門家の一人は、米Patriot ConsultancyのRick Field氏。世界最大の生活者データを有する米Acxiomでデータ解析やコンサルティングを手掛け、その後、独立したデータ分析のプロだ。もう一人は米GoogleのJordan Tigani氏。同社のソフトウェアエンジニア(Software Engineer)を務め、『Google BigQuery』の著者である。

「あらゆる企業がビッグデータを扱うべきだ」

両氏のプレゼン資料を元にビッグデータ分析の今を紹介しよう。Rick Field氏は、改めてビッグデータを認識することが重要だと述べ、ビッグデータを次のように定義した。

どのデータを消去するのかを解き明かすためのコストが、データをただそのまま永久に格納しておくコストを上回る状態にある時、その企業はビッグデータと関わりを持っていると言える。

そうしたケースでは、データを永久に保持し続けようと思えば、発生した事象そのものの記録を完璧に保持することができる。データを役立つものにしようと蓄積する必要さえない。

ふと思い立ち、格納された生のデータに立ち戻って別の質問を投げかけたいと思えば、いつでもそれができる

データを格納するコストは急激に下がり続けている。今、あるいは近いうちにどんな企業もビッグデータを扱うようになるという趣旨だ。

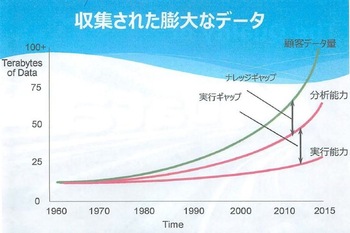

図1:収集された膨大なデータ量に対し、分析力・実行力が追いつかない

図1:収集された膨大なデータ量に対し、分析力・実行力が追いつかない拡大画像表示

同氏の定義には、「ふと思い立ち、質問を投げかけようと思えば、いつでもそれができる」とあるが、いざ活用しようとすると課題は少なくない。過去数年、データは急増してきたし、そのペースは今後、さらに上がる。そのため、分析の能力と、分析を実行する能力は、データ量に対して大きく乖離しているという(図1)。

「世の中で収集されるデータ量は向こう5年間で800%に達する。一般的な企業では、そのうち10%で十分であるにせよ、どの10%かが分からない点が問題になる」。

問題はほかにもある。Rick Field氏によると、データを利用するシステムに不備がある企業は94%、データ統合ができていない企業は70%、データに関する技術的なスタンタードを持たない企業は80%など、多くの企業が必要なデータ品質を達成できていないと指摘する。

「クリーンで汚れていないデータに、リアルタイムにアクセスすることができなければ、企業は生きていることさえもままならなくなる。このことをもっと重要視し、企業は今すぐデータに関するプランを作成する必要がある」。

「ビッグデータを発明したのはGoogleだ」

データに関するプランとは,どんなものか?Rick Field氏から話を引き継いだJordan Tigani氏が、それを説明した。同氏は冒頭で「ビッグデータを発明したのはGoogleだ」と強調した。「Googleが創業する以前から、大量のデータを処理するために様々なアプローチが試みられてきた。共通点はハードウェアの規模拡大、つまりスケールアップだった。しかし創業当初、Googleには高価なハードウェアを導入する資金がなかった。あったのはソフトウェアのエンジニアリング能力だ」。

続けてこうも話す。「ソフトウェアエンジニアリング能力を生かしGoogleは、安価なサーバーで並列分散処理するスケールアウトのシステムを作った。今日のビッグデータへの第1歩である。大量の安価なサーバーは次々に故障するが、それをソフトウェアで乗り越え、データ量がどうあれ対処できるようにした」。

Google Cloud / アナリティクス / BigQuery / Bigtable / Spanner

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-