[市場動向]

NICTと東京大、複数のGPUによる並列学習を自動化する深層学習ミドルウェア「RaNNC」を公開

2021年3月31日(水)日川 佳三(IT Leaders編集部)

情報通信研究機構(NICT)と東京大学は2021年3月31日、共同研究を通じて開発したディープラーニング(深層学習)ミドルウェア「RaNNC(Rapid Neural Net Connector)」をGitHubに公開した。ニューラルネットワークを自動的に分割することによって、複数のGPUを用いた並列学習を容易に実現できるとしている。ライセンスはMITライセンスであり、商用目的を含めて無料で利用できる。

「RaNNC(Rapid Neural Net Connector、ランク)」は、ニューラルネットワークを自動的に分割することによって、複数のGPUを用いた並列学習を容易に実現できる深層学習ミドルウェアである。情報通信研究機構(NICT)データ駆動知能システム研究センターと東京大学情報基盤センターが共同研究を通じて開発した。GitHubで公開している。ライセンスはMITライセンスであり、商用目的を含めて無料で利用できる。

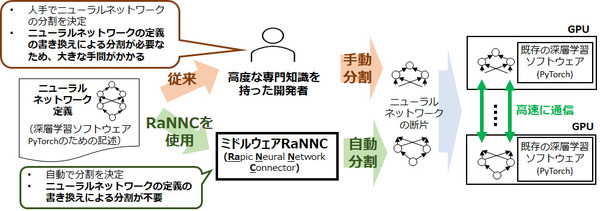

RaNNCは、Python用の代表的な深層学習ライブラリであるPyTorchのために記述した既存のニューラルネットワークの定義を与えると、実行速度を最適化しつつ、各々のGPUのメモリーに収まるように、自動的にニューラルネットワークを分割する。こうして、複数のGPUを使い、並列に学習を行う(図1)。

図1:大規模ニューラルネットワークの並列学習(出典:情報通信研究機構、東京大学)

図1:大規模ニューラルネットワークの並列学習(出典:情報通信研究機構、東京大学)拡大画像表示

ニューラルネットワークを分割するために開発者がニューラルネットワークの定義を書き換える必要がない。このため、大規模なニューラルネットワークを学習しやすくなる。既存ソフトウェア(Megatron-LMやMesh-TensorFlow)と異なり、適用できるニューラルネットワークの種類に制約がない。

NICTの計算機環境における既存ソフトウェアとの比較実験では、RaNNCはMegatron-LMより約5倍の規模のニューラルネットワークを学習できる一方、同一規模のニューラルネットワークでは、ほぼ同等の学習速度を実現している。

NICTデータ駆動知能システム研究センターでは、これまで収集してきた高品質な日本語テキスト約350GBを学習データとし、RaNNCを用いて、BERTを約50億パラメータ(原論文の15倍)に大規模化したニューラルネットワークを学習している。

●Next:ニューラルネットワーク学習時の課題を解決─RaNNCを開発した背景

会員登録(無料)が必要です

- 1

- 2

- 次へ >

東京大学 / RaNNC / NICT / ディープラーニング / OpenAI / BERT / 大規模言語モデル / 産学官連携 / 協業・提携 / GPT / 生成AI / ニューラルネットワーク

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-