[市場動向]

「小規模なAI推論処理はデータの発生場所で処理せよ」─インテルが“AI Everywhere”を強調

2023年12月18日(月)日川 佳三(IT Leaders編集部)

インテルは2023年12月18日、説明会を開き、エッジからクラウドまで全範囲でAI処理を実行するコンセプト「AI Everywhere」についての開発動向を紹介した。「エッジでも動作可能な小規模な推論処理であれば、クラウドではなくデータの発生場所で処理するほうが遅延なく効率的だ」としている。実現手法として、サーバー/クライアントPC用CPU、AI用プロセッサーの処理性能をを高めている。

写真1:「第5世代インテル Xeonスケーラブル・プロセッサー」を手にする、インテル代表取締役社長の鈴木国正氏

写真1:「第5世代インテル Xeonスケーラブル・プロセッサー」を手にする、インテル代表取締役社長の鈴木国正氏拡大画像表示

インテルが提唱する「AI Everywhere」は、エッジからクラウドまで全範囲でAI処理を実行するコンセプトである。現在はクラウドでAIの演算を実行しているが、今後は推論の一部をローカルで処理するようになるという。

同社は米ガートナーの「2025までに企業が管理する50%以上のデータはクラウドやデータセンターの外で生成され、処理される」という予測を引用し、コンセプトの説明を補足した。

大規模言語モデル(LLM)の学習のような大規模な演算は、依然としてクラウドが適しているという。一方で、小規模なLLMを用いた推論など、比較的小さな処理能力でも動作するユースケースについては、データの発生場所で処理したほうが遅延もなく効率がよいとインテルは指摘。「病院など機密性の高いデータを扱う場面でもローカルでデータを処理する需要は高い」(同社)と説明した。

コンセプトを実現するアプローチの1つとしてインテルは、サーバーやクライアントPCのCPU、AI処理用プロセッサの処理能力を向上させている。2023年12月14日には、サーバー/クライアントPC向けの新CPUを発表している。

サーバー向けの「第5世代 インテル Xeonスケーラブル・プロセッサー」(写真1・2)は、現行の第4世代とピン互換で性能を高めている。CPUあたりコア数は従来より4コア増えて最大64コアとなった。メモリー性能は4800MT/s(1秒あたり転送回数が48億回)から5600MT/s(同56億回)に、L3キャッシュ容量は3倍の最大320MBに拡大している。

写真2:サーバー向けの「第5世代 インテル Xeonスケーラブル・プロセッサー」(出典:インテル)

写真2:サーバー向けの「第5世代 インテル Xeonスケーラブル・プロセッサー」(出典:インテル)拡大画像表示

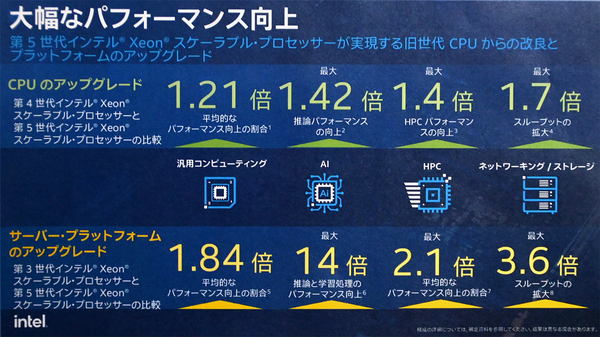

図1:「第5世代インテル Xeonスケーラブル・プロセッサー」の処理性能を第4世代/第3世代と比較(出典:インテル)

図1:「第5世代インテル Xeonスケーラブル・プロセッサー」の処理性能を第4世代/第3世代と比較(出典:インテル)拡大画像表示の

第5世代インテル Xeonにおけるユースケースごとの性能向上率を、現行CPU(第4世代/第3世代)と比較したのが図1である。第4世代Xeonと比べて平均性能は1.21倍にに、AI推論性能は最大1.42倍に、HPC(High Performance Computing)性能は最大1.4倍に向上している。ネットワーク/ストレージの転送速度は最大1.7倍向上している。

PC向けの「インテル Core Ultraプロセッサー」では3Dパッケージング技術を採用。処理性能にすぐれるPコア、電力効率にすぐれるEコアに加えて、より低電力消費のLP Eコアを追加した。また、AI処理用のNPU(Neural Processing Unit)を搭載したほか、内蔵GPUの処理性能を高めている。

Intel / Xeon / CPU / エッジコンピューティング

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-