[市場動向]

NEC、1つのGPUで動作する、軽量な130億パラメータの日本語大規模言語モデルを開発

2023年7月6日(木)日川 佳三(IT Leaders編集部)

NECは2023年7月6日、日本語の大規模言語モデル(LLM)を開発したと発表した。同社が挙げる特徴は、日本語能力の高さと、1つのGPUでも動作するように130億パラメータと軽量設計ながら性能が高いこと。NECは、同LLMをすでに社内業務で活用している。社内システム開発におけるソースコード作成工数を80%削減するなど各種の成果を挙げている。また、LLMを顧客企業の業務に適用するサービス群「NEC Generative AI Service」も提供する。生成AI関連事業において今後3年間で約500億円の売上を目指す。

NECは、日本語の大規模言語モデル(LLM)を独自に開発した。同社が挙げる特徴は、日本語能力の高さと、1つのGPUでも動作するように130億パラメータに抑えて軽量化を図ったこと。NECは、同LLMをすでに社内業務で活用しており、社内システム開発におけるソースコード作成工数を80%削減するなど、各種の成果を挙げている(図1)。

図1:NECのLLMによる出力結果の例(文書の生成)(出典:NEC)

図1:NECのLLMによる出力結果の例(文書の生成)(出典:NEC)拡大画像表示

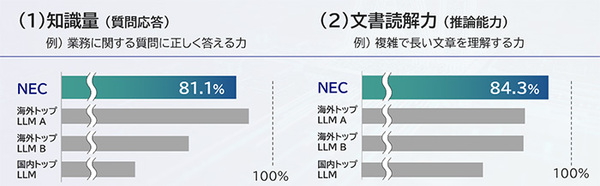

日本語能力については、自然言語処理分野のベンチマークである「日本語言語理解ベンチマークJGLUE」を用いて評価したところ、知識量に相当する質問応答で81.1%、推論能力に相当する文書読解において84.3%だったという(図2)。いずれも、世界トップレベルの性能に相当する。

図2:日本語言語理解ベンチマークJGLUEを用いてNECが評価した結果(出典:NEC)

図2:日本語言語理解ベンチマークJGLUEを用いてNECが評価した結果(出典:NEC)拡大画像表示

軽量化については、学習データの量と学習時間を増やす工夫により、性能を維持したままパラメータサイズを1枚のGPUで動作する範囲(130億パラメータ)に抑えた。従来のLLMが複数(8個以上など)のGPUを必要とするのに対し、NECのLLMは標準的な構成のサーバー機やPCで動作する。

ハードウェアの要求スペックが低く済むことから、LLMを組み込んだ業務アプリケーションがレスポンス良く動作するほか、業務運用時の電力消費やサーバーコストを抑えられる。ユーザーの業務に特化させたLLMも、より短期間で構築可能である。オンプレミス環境でも動作するため、秘匿性の高い業務にも適する。

LLMの学習には、NECが2023年3月に稼働させたAI研究用のスーパーコンピュータを活用した(関連記事:NEC、580PFLOPS超のAI研究用スパコンを2023年3月に稼働、数百人のAI研究者が利用)。1ノードあたり8個のGPU「NVIDIA A100 80GB Tensor コア GPU」を搭載したサーバー116台(合計で928枚のGPU)を使って約1カ月で構築した。

NECは、同LLMを2023年5月から社内業務で活用している。社員が安全にLLMを使える体制と仕組みを2週間で構築した。社内チャットで利用するほか、Web会議ツールなどの社内システムとも連携している。約2万人の利用者が、合計で1日あたり約1万回使っている。社内利用の効果として、資料の作成時間を50%削減し、議事録の作成時間を平均30分から約5分に短縮した。また、社内システム開発におけるソースコードの作成工数を80%削減した。

NECは今後、今回開発したLLMをもとに、ユーザーが保有するデータを用いた個社向けLLMの開発を推進する。また、LLMの基盤モデル自体の性能改良も進める。

●Next:ユーザー環境にLLMを提供・導入するサービスの内容

会員登録(無料)が必要です

- 1

- 2

- 次へ >

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-