[市場動向]

Python用「vLLM」、AIエージェント開発API「Llama Stack」、Linux新版「RHEL 10」など─Red Hat Summit 2025での主な発表

2025年6月4日(水)日川 佳三(IT Leaders編集部)

レッドハットは2025年6月4日、説明会を開き、米国本社が同年5月に開催した「Red Hat Summit 2025」で発表された主な技術・製品・サービスについて紹介した。AI関連では、新製品「Red Hat AI Inference Server」(LLM推論エンジンのvLLMおよびLLM軽量化ツール)、「llm-d」(Kubernetesベースの分散推論基盤)、「Llama Stack」(Metaと共同開発するAIエージェント開発用API)などを説明した。

レッドハットは都内で説明会を開き、本社が2025年5月に米ボストンで開催した年次プライベートイベント「Red Hat Summit 2025」で発表された主な技術・製品・サービスについて紹介した。

同イベントでは多くのAI関連の発表がなされた。新製品「Red Hat AI Inference Server」は、LLM推論エンジンの「vLLM」とLLM軽量化ツール「LLM Compressor」で構成する。vLLMは、LLMの推論をメモリー管理などによって高速化するPython用のオープンソースライブラリである。

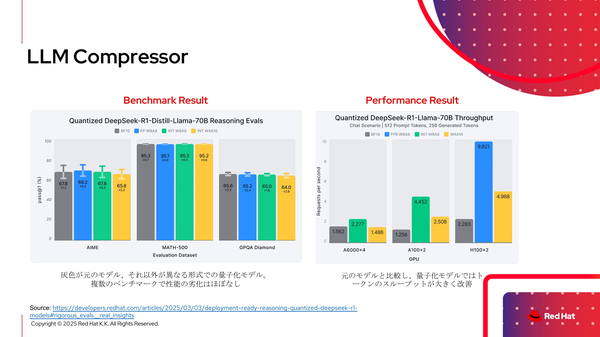

一方のLLM Compressorは、既存のLLMを“量子化”(16ビットから8ビットや4ビットなどに軽量化)する。例えば、bfloat16で構築されたモデルをFP8やINT8/INT4など軽量なものにサイズダウンする。性能を維持したまま、より少ないリソースで高速に動作させられるという。レッドハットは、同社が軽量化した各LLMをHugging Faceで公開している(図1)。

図1:「LLM Compressor」で軽量化したLLMのベンチマーク結果(出典:レッドハット)

図1:「LLM Compressor」で軽量化したLLMのベンチマーク結果(出典:レッドハット)拡大画像表示

Kubernetesベースの分散推論基盤「llm-d」プロジェクトが発表された。KubernetesとvLLM、負荷分散用のInference Gatewayなどが主要なコンポーネントとなる。

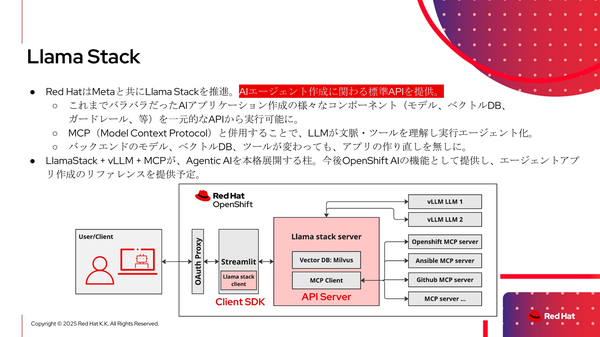

また、米Metaとの共同プロジェクトとして「Llama Stack」を推進する。AIエージェントを作成するための標準APIを提供するもので、AIアプリケーションを構成する各種コンポーネント(モデル、ベクトルデータベース、ガードレールなど)を一元的なAPIを介して利用できるようにする。バックエンドでMCP(Model Context Protocol)も併用可能である(図2)。

図2:AIエージェントを作成するための標準APIを提供する「Llama Stack」(出典:レッドハット)

図2:AIエージェントを作成するための標準APIを提供する「Llama Stack」(出典:レッドハット)拡大画像表示

●Next:Linux OS新版「RHEL 10」でブート可能なコンテナイメージを提供

会員登録(無料)が必要です

- 1

- 2

- 次へ >

Red Hat / Red Hat Enterprise Linux / 生成AI / コンテナ / 大規模言語モデル / OpenShift / Llama / Meta / マイクロサービス / Kubernetes

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-