[市場動向]

富士通、1ビット量子化ソフトをGitHubで公開、1.4nm設計のCPU「MONAKA-X」は2029年リリース

2025年12月2日(火)IT Leaders編集部、日川 佳三

富士通は2025年12月2日、技術開発の説明会を開き、AI、CPU、量子コンピュータなどの直近の取り組みを説明した。AI領域では、AIモデルを軽量化する1ビット量子化ソフトウェアを同日付でGitHubで公開。合わせて、生成AIの偽・誤情報対策に取り組む国際コンソーシアム「Frontria」を設立している。CPUについては、富岳NEXTに搭載予定の「MONAKA-X」などのロードマップを示した。

富士通は、同社の技術開発に関する説明会で、AI、CPU、量子コンピュータなど各領域での直近の取り組みを紹介し、開発ロードマップを示した。

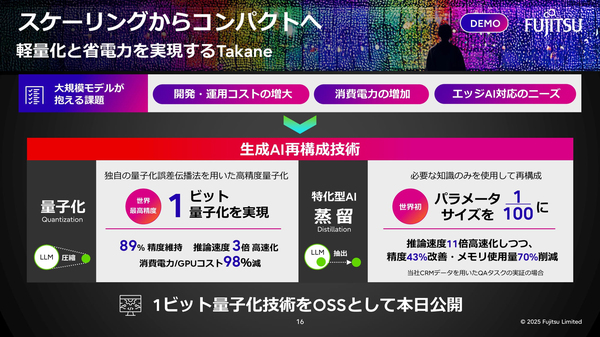

AI領域では、大規模言語モデル(LLM)を軽量化する1ビット量子化ソフトウェアを、2025年12月2日にオープンソースソフトウェア(OSS)としてGiHubに公開した(GitHub)。Pythonで開発している(図1、関連記事:富士通、1ビット量子化でLLMを軽量化、精度を89%維持してメモリー消費を94%減)。

図1:LLMを軽量化する1ビット量子化ソフトウェア(開発言語はPython)をOSSとしてGiHubに公開した(出典:富士通)

図1:LLMを軽量化する1ビット量子化ソフトウェア(開発言語はPython)をOSSとしてGiHubに公開した(出典:富士通)拡大画像表示

量子化とは、計算精度であるビット数を粗くして軽量化する手法のこと。AI向けの計算は、もともと精度が低めの半精度(16ビット)や8ビットの演算を使うが、富士通が採用した1ビット(2値)は、ビット表現としては最も低い。同社のベンチマークテストでは、16ビット(FP16)を1ビット(INT1)に圧縮しても出力精度は89%を維持したという。

AIモデルを軽量化する別のアプローチとして、特化型のAI蒸留技術を紹介した。AI蒸留は、教師モデルの出力を学習することで教師モデルの知識を小さなモデルに転移させる技術。富士通は、特定のユースケースの知識を使って専用モデルを再構築することで、教師モデルを超える精度を、より軽量な100分の1のパラメータサイズのモデルで達成できることを確認している。

加えて同社は、企業データをナレッジグラフに変換してLLMに参照させる「ナレッジグラフ拡張RAG」を示した(図2)。知識をナレッジグラフとして表現することで、より多くの知識をヒントとして生成AIに渡せるようにする(関連記事:富士通、業務特化の生成AI構築のための「エンタープライズ生成AIフレームワーク」を提供)。

図2:企業データをナレッジグラフに変換してLLMに参照させる「ナレッジグラフ拡張RAG」の概要(出典:富士通)

図2:企業データをナレッジグラフに変換してLLMに参照させる「ナレッジグラフ拡張RAG」の概要(出典:富士通)拡大画像表示

AIエージェントの高度活用の試みとしては、マルチAIエージェント連携技術を開発している。サプライチェーン構成企業のそれぞれで動作するAIエージェント同士が、自律的に判断・交渉しながら全体最適を図る仕組み。情報が不完全な状況下でも全体最適制御が可能になる(図3、関連記事:ロート製薬、企業間AIエージェント連携でサプライチェーンを最適化、検証では運搬コストを3割減)。

図3:マルチAIエージェント連携技術の概要(出典:富士通)

図3:マルチAIエージェント連携技術の概要(出典:富士通)拡大画像表示

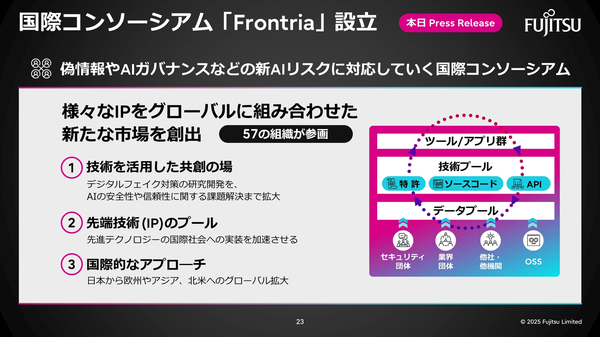

AI領域の新たな取り組みとして、偽・誤情報対策や安全な運用などのAIリスク対策に取り組む国際コンソーシアム「Frontria」を設立している。世界中から50以上の組織が参画し、技術や知見を持ち寄り、アイデア創出の場を提供する。早期に具体的なアプリケーションやサービスを開発し、活用事例を国内外に展開するとしている(図4)。

図4:富士通が設立した、AIリスク対策に取り組む国際コンソーシアム「Frontria」の概要(出典:富士通)

図4:富士通が設立した、AIリスク対策に取り組む国際コンソーシアム「Frontria」の概要(出典:富士通)拡大画像表示

●Next:富岳NEXTに搭載する次世代CPU「MONAKA-X」

会員登録(無料)が必要です

- 1

- 2

- 次へ >

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-