[市場動向]

NTT、特化型AIモデルにおいて基盤モデルの更新時の再学習を不要にする「ポータブルチューニング」技術

2025年7月9日(水)日川 佳三(IT Leaders編集部)

NTTは2025年7月9日、特化型AIモデルにおいて、基盤モデル更新時の再学習を不要にする「ポータブルチューニング」技術を確立したと発表した。基盤モデルの出力を調整する独立したモデルを学習および再利用することで、別の基盤モデルにも追加学習を行うことなく学習内容を引き継げるようになる。

NTTは、特化型AIモデルにおいて、基盤モデル更新時の再学習を不要にする「ポータブルチューニング」技術を確立した。基盤モデルの出力を調整する独立したモデルを学習および再利用するという、新たな特化学習の仕組みにより、別の基盤モデルにも追加学習を行うことなく学習内容を引き継げるようになる。

現状、各ドメイン知識に特化したAIモデルは、ベースとなる基盤モデルに各ドメイン知識を追加学習させるファインチューニングによって構築している。基盤モデルは知識の最新化やモデル構造の変更などにより定期的に更新されるので、その更新に特化モデルを追随させるためには、更新/変更のたびに再学習が必要となる。

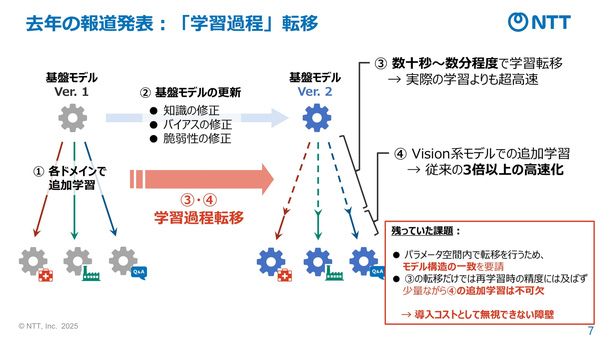

こうした中でNTTは2024年5月、異なる基盤モデル間で学習結果を転移させる「学習過程転移」と呼ぶ方法を発表した。しかし、この方法には2つの課題が残ったという。パラメータ空間内で転移を行うため、転移元と転移先のモデル構造が一致する必要があることと、実用上の高い精度を達成するためには、少量ながら転移後の追加学習が必要であることである(図1)。

図1:NTTが2024年に発表した、異なるモデル間で学習結果を転移させる方法の概要と課題(出典:NTT)

図1:NTTが2024年に発表した、異なるモデル間で学習結果を転移させる方法の概要と課題(出典:NTT)拡大画像表示

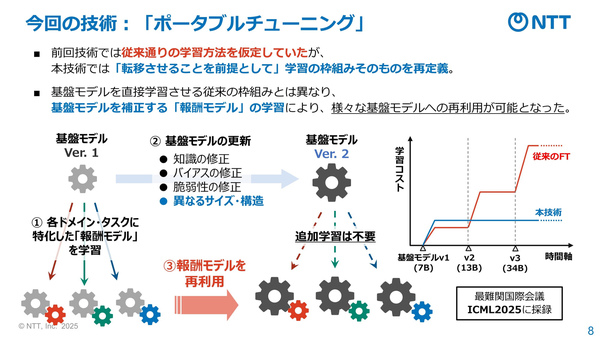

今回開発したポータブルチューニングは、モデル間で学習内容を転移させることを前提に、学習の枠組みそのものを再定義している。基盤モデルによる推論時の出力を各ドメインに合わせて補正するというアプローチをとる。補正に用いる報酬モデルを学習によって作成する(図2)。

図2:NTTが今回開発した、基盤モデル更新時の再学習を不要にする「ポータブルチューニング」技術の概要(出典:NTT)

図2:NTTが今回開発した、基盤モデル更新時の再学習を不要にする「ポータブルチューニング」技術の概要(出典:NTT)拡大画像表示

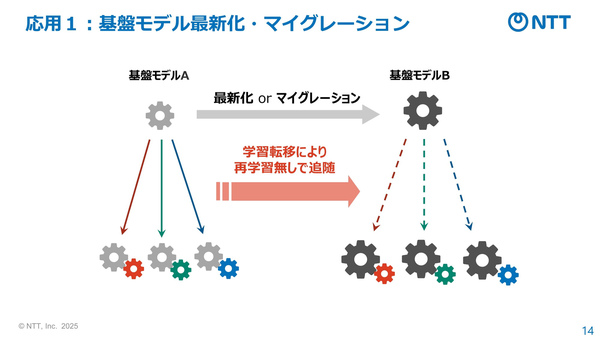

報酬モデルは、各種の基盤モデルで再利用できるので、追加学習することなく学習内容の転移可能である。また、出力を補正するだけなので、モデル構造が異なっていても利用可能である(図3)。

図3:ポータブルチューニング技術のユースケースの1つ、異なる基盤モデルへのマイグレーションの例(出典:NTT)

図3:ポータブルチューニング技術のユースケースの1つ、異なる基盤モデルへのマイグレーションの例(出典:NTT)拡大画像表示

NTTは、ポータブルチューニング技術により、各企業・組織での特化モデルの再学習コスト削減だけでなく、再学習を行った場合に期待される効果を同技術で事前にシミュレーションするといった応用も期待できるとしている。「今後、大規模化するAIのコスト問題解決や多数のAIを連携させるAIコンステレーション(注1)の具現化につながる次世代技術の研究開発に貢献していく」(同社)。

注1:AIコンステレーション(AI Constellation)は、多様なAIモデルやルールを環境として与えることでAI同士が相互に議論・訂正を行い、人が要因推測すら困難な問題に対し、多様な視点から解を創出する、NTTの大規模AI連携技術の構想。2023年度より研究開発を推進している。

NTT / 大規模言語モデル / R&D / 生成AI / ファインチューニング

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-