[新製品・サービス]

HPE、オンプレミスに設置可能なAI処理基盤「HPE Private Cloud AI」を発表

2024年8月1日(木)日川 佳三(IT Leaders編集部)

ヒューレット・パッカード エンタープライズ(HPE/日本ヒューレット・パッカード)は2024年7月31日、ラック型AIシステム「HPE Private Cloud AI」を同年末までの予定で提供すると発表した。オンプレミス環境に設置可能なAI処理基盤として、サーバー/ストレージ、ミドルウェアを設定済みの状態で提供する。オンプレミスのITインフラをサービス型で利用可能な「HPE GreenLake」を通じて提供する。

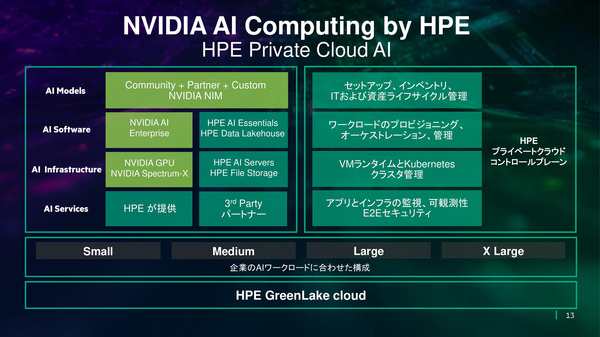

ヒューレット・パッカード エンタープライズ(HPE)の「HPE Private Cloud AI」は、オンプレミスのデータセンター/サーバールームに設置するラック型AIシステムである。大規模言語モデル(LLM)を用いるAIアプリケーションに必要なサーバー/ストレージやミドルウェアを、インストール/設定済みで提供する(図1)。

設置後、ウィザードからIPアドレスなどを設定し、数クリックで使い始められるようになるとしている。オンプレミスのITインフラをサービス型の課金形態で利用可能な「HPE GreenLake」を通じて提供する。

図1:ラック型AI処理基盤「HPE Private Cloud AI」のソフトウェア構成(出典:日本ヒューレット・パッカード)

図1:ラック型AI処理基盤「HPE Private Cloud AI」のソフトウェア構成(出典:日本ヒューレット・パッカード)拡大画像表示

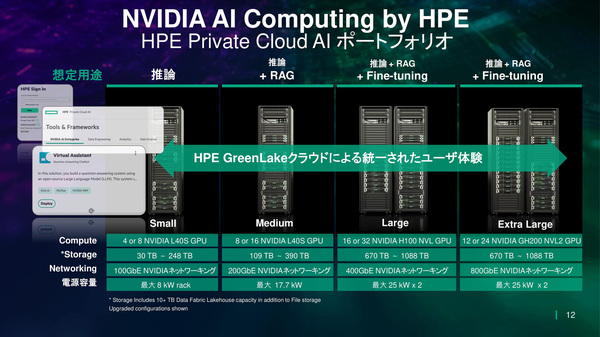

スペックに応じて4つの構成をラインアップする。搭載するGPUは、最小構成の「Small」がNVIDIA L40S(4または8基)、最大構成の「Extra Large」がNVIDIA GH200 NVL2(12または24基)である。冷却方式はコールドプレートによる液冷方式を採用する(図2)。

図2:ラック型AI処理基盤「HPE Private Cloud AI」のラインアップ(出典:日本ヒューレット・パッカード)

図2:ラック型AI処理基盤「HPE Private Cloud AI」のラインアップ(出典:日本ヒューレット・パッカード)拡大画像表示

1ラック構成のSmallは通常の推論用で、LLMを用いたAIアプリケーションを社内で運用する用途に向く。Medium(1ラック構成)は、RAG(Retrieval-Augmented Generation:検索拡張生成)構成の推論AIシステムの運用に必要なスペックを備えている。2ラック構成のLargeとExtra Largeは、RAGに加えてLLMに追加学習(ファインチーニング)を施すようなハイエンド用途に向けて提供する。

HPE Private Cloud AIで動作するソフトウェアは、インフラとして、Kubernetesによるコンテナ運用基盤とワークロードのプロビジョニング/管理などを担う。その上で動作するAIシステム構築のためのソフトウェアとして、データレイク/ストレージやNVIDIAのAIソフトウェア群を提供する。

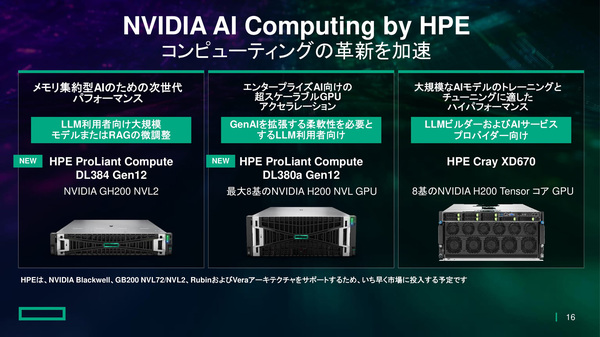

上記のラック型システムに加えて、ラックマウント型PCサーバー「HPE ProLiant」にAI用途の2つの新モデルを追加している。2024年夏に提供開始の「HPE ProLiant DL384 Gen12」は2Uサイズで、GPUにNVIDIA GH200を搭載する。同年秋に提供開始する「HPE ProLiant DL380a Gen12」は4Uサイズで、GPUにNVIDIA H200を8基搭載する(図3)。

図3:ラックマウント型PCサーバー「HPE ProLiant」に追加したGPUサーバー新モデルの概要(出典:日本ヒューレット・パッカード)

図3:ラックマウント型PCサーバー「HPE ProLiant」に追加したGPUサーバー新モデルの概要(出典:日本ヒューレット・パッカード)拡大画像表示

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-