大日本印刷(DNP)と電気通信大学(UEC)は2017年8月7日、人間の言葉や表情、ジェスチャーに合わせて、自動的にその返答とジェスチャーを生成する「表現AI」の研究を開始したと発表した。

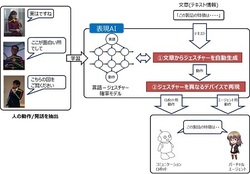

図1●「表現AI」の概要(出所:大日本印刷)

図1●「表現AI」の概要(出所:大日本印刷) 拡大画像表示

研究の成果として、情報デバイス(ロボット、チャットボット、デジタルサイネージなど)がジェスチャー付きで会話を行えるようにする「表現AI」のプロトタイプを、2017年度中に開発する。その後、実際の情報デバイスを利用した自動プレゼンテーションの実証実験を行う予定。今後は、店舗での案内やECサイトなどでの顧客対応といった生活者とのコミュニケーションを支援するサービスへの展開を目指す。

今回DNPとUECは、人間のジェスチャーや表情、言語から相手の状況を自律的に分析して、返答するテキスト情報(言語)やジェスチャーなどを自動的に生成する「表現AI」を開発する。

まず、文章からジェスチャーを自動生成するライブラリを開発する。大量の人間の映像情報から、教師なし学習の手法によって、返答する言葉とジェスチャーを合わせて抽出し、その相関関係を分析したモデルを構築する。次に、生成した「ジェスチャー情報」を、コミュニケーションロボットをはじめとした各種の情報デバイスで再現する。

DNPは2014年から、人間と情報デバイスとの円滑な情報のやり取りを支援する「知能コミュニケーションプラットフォーム」の構築を進めている。情報デバイスが相手の状況を推定して適切なコミュニケーションが行えることを目指しているが、従来のAI技術では言語とジェスチャーの相関関係付けは人間の判断(プログラマーによる設定)が必要になっていたという。

UECは、AIが自律的に概念を学ぶ方法として、周囲の状況を観察・行動しながら異なる相手との相関関係を分析して自律的に成長していく「記号創発ロボティクス」の研究を進めている。人間の発する言葉やジェスチャーなどの意味を機械が理解し、より円滑なコミュニケーションを実現する基盤技術の確立を目指している。

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-