EYストラテジー・アンド・コンサルティング(EYSC)は2023年6月22日、AIの利用や開発・運用を律するガバナンスの構築を支援するサービスを開始すると発表した。AIを使う上で発生する各種のリスク(信頼性・正確性、プライバシー、知的財産権など)を統制するための体制やルール、プロセスを整備する。

EYSCは、AIの利用や開発・運用を律するガバナンスの構築を支援するサービスを開始する。AIを使う上で発生する各種のリスク(信頼性・正確性、プライバシー、知的財産権など)を統制するための体制やルール、プロセスを整備する。

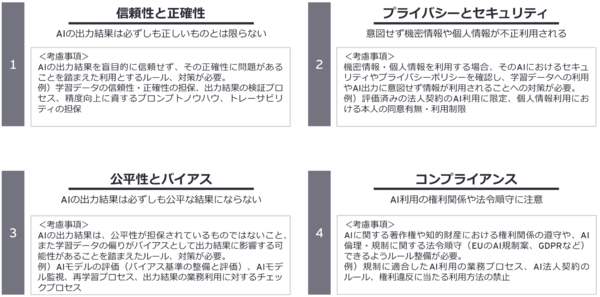

現在、ChatGPTなど生成AIに対する関心の高まりにあわせ、企業においてもAIの利用や、AIと連携したサービスの開発・利用が進んでいる。一方、AIには各種のリスクが存在する(図1)。AIのリスクを統制するAIガバナンスの構築が必要である。

図1:AIを使ううえで生じるリスク(出典:EYストラテジー・アンド・コンサルティング)

図1:AIを使ううえで生じるリスク(出典:EYストラテジー・アンド・コンサルティング)拡大画像表示

EYSCは、2つのAIガバナンスが必要という。1つは、利用者が誤った方法でAIを利用することにより発生するリスクを防ぐ「AI利用のためのガバナンス」。もう1つは、企業がAIモデルを含むシステムを開発・運用する際に、そのライフサイクルにおいて必要な対応を行う「AI開発・運用のためのガバナンス」である。

これら2つのガバナンスを構築するサービスを、それぞれ提供する。

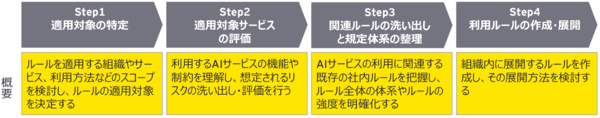

(1)「AI利用のためのガバナンス構築支援サービス」は、法規制や各種ガイドラインをベースに、ユーザーの社内規定類と整合を取りながら、エンドユーザーがAIを利用する際の管理体制やルールなどの構築を支援する(図2)。

図2:「AI利用のためのガバナンス構築支援サービス」の内容(出典:EYストラテジー・アンド・コンサルティング)

図2:「AI利用のためのガバナンス構築支援サービス」の内容(出典:EYストラテジー・アンド・コンサルティング)拡大画像表示

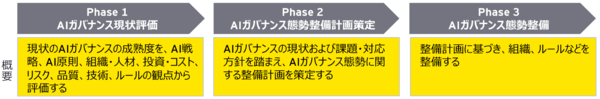

(2)「AI開発・運用のガバナンス構築支援サービス」は、システム開発のライフサイクルに沿って、AIを含むシステム/サービスを開発・運用する際のガバナンスの現状を評価し、改善点を明らかにしたうえで、管理体制やルールなどの強化を支援する(図3)。

図3:「AI開発・運用のガバナンス構築支援サービス」の内容(出典:EYストラテジー・アンド・コンサルティング)

図3:「AI開発・運用のガバナンス構築支援サービス」の内容(出典:EYストラテジー・アンド・コンサルティング)拡大画像表示

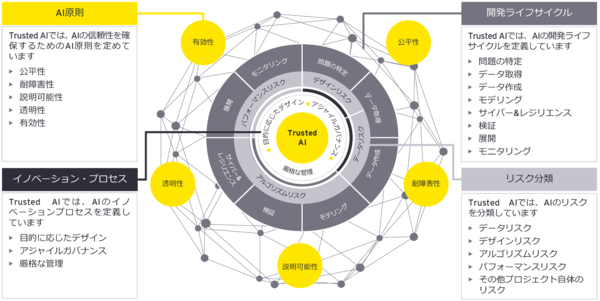

なお、EYSCはグローバルにおいて、AIガバナンスのフレームワーク「Trusted AI」を定め、ガバナンスの構築を支援している(図4)。同フレームワークは、「AI原則」、「開発ライフサイクル」、「リスク分類」の3層でリスクを整理し、個々のリスクに対するコントロールを定義している。

図4:AIガバナンスのフレームワーク「Trusted AI」の概要(出典:EYストラテジー・アンド・コンサルティング)

図4:AIガバナンスのフレームワーク「Trusted AI」の概要(出典:EYストラテジー・アンド・コンサルティング)拡大画像表示

EY / ガバナンス / AI倫理 / ITコンサルティング / 生成AI

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-