マクニカとneoAIは2025年3月7日、オンプレミス/ローカルで動作する生成AIシステムのSIサービスの提供で協業すると発表した。neoAIがLlama 3.1、Gemini 2、neoAI独自開発の日本語LLMなどを用いたローカルLLMを提供し、マクニカがシステムを構築する。構築から導入、伴走支援までワンストップで支援する。

マクニカとneoAIは、オンプレミス/ローカルで動作する生成AIシステムのSIサービスの提供で協業する。

情報漏洩・流出などの懸念から、LLM(大規模言語モデル)をオンプレミスで利用するローカルLLMの構築に注目が集まっている。「設計/製造プロセスのデータや顧客情報といった機密性の高いデータを扱う業務では、クラウドのLLMの利用を躊躇するケースがある。ローカルLLMでは、セキュリティ面に加えて、企業固有の業務やタスクに特化した利用や、長期的なコスト抑制といったメリットもある」(両社)。

ただし、多くの企業にとってローカルLLMの構築はハードルが高い。ITインフラではGPUサーバーの調達などが必要なうえ、LLMの推論・学習やRAG(検索拡張生成)構成のノウハウなどが問われる。構築後も生成AIアプリケーションの開発・保守、回答精度向上のためのチューニングなどに取り組む必要がある。

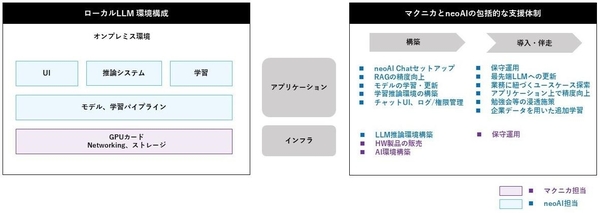

図1:オンプレミス/ローカルで動作する生成AIシステムSIサービスの概要(出典:マクニカ、neoAI)

図1:オンプレミス/ローカルで動作する生成AIシステムSIサービスの概要(出典:マクニカ、neoAI)拡大画像表示

マクニカとneoAI、こうした課題を持つ企業に向けてローカルLLMのSIサービスを提供する。neoAIがLlama 3.1、Gemini 2、neoAI開発の日本語LLMなどを用いたローカルLLMを提供し、マクニカがITインフラ/システムを構築する。構築後のシステム運用や生成AIアプリケーションの活用を伴走型で支援する(図1)。

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-