[市場動向]

東工大など、スパコン「富岳」でLLMを学習、130億パラメータの「Fugaku-LLM」を公開

2024年5月10日(金)日川 佳三(IT Leaders編集部)

東京工業大学、東北大学、富士通、理化学研究所、名古屋大学、サイバーエージェント、Kotoba Technologiesの7組織は2024年5月10日、スーパーコンピュータ「富岳」で大規模言語モデル(LLM)を学習する研究成果として、130億パラメータのLLM「Fugaku-LLM」を公開した。富岳の計算資源1万3824ノードを約1カ月間占有して学習させて構築したもので、日本語の能力が高いとしている。

東京工業大学(2024年10月に東京医科歯科大学との統合で東京科学大学に名称変更)、東北大学、富士通、理化学研究所、名古屋大学、サイバーエージェント、Kotoba Technologiesの7組織は、2024年3月末にかけて、スーパーコンピュータ「富岳」(写真1)で大規模言語モデル(LLM)を効率的に学習する研究を実施した。

2024年5月10日に、研究成果となるソフトウェアの実装をGitHubおよびHugging Faceで公開した(関連記事:「富岳」を活用して、大規模言語モデルの効率的な開発手法を研究─東工大、東北大、富士通、理研)。

写真1:スーパーコンピュータ「富岳」の外観(出典:富士通、理化学研究所)

写真1:スーパーコンピュータ「富岳」の外観(出典:富士通、理化学研究所)拡大画像表示

成果物の1つは、130億パラメータのLLM「Fugaku-LLM」である。富岳の計算資源1万3824ノード(富岳の全15万8976ノードの10%弱)を約1カ月間占有し、約4000億トークンを学習させた。選択したパラメータ数とトークン数は、利用可能な富岳のノード数と学習期間の制約の下、可能なかぎり高性能なLLMの構築を目的に決定した。

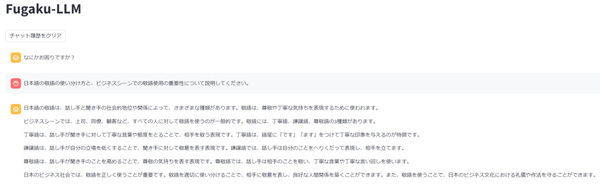

学習データの約60%を日本語コンテンツが占め、日本語能力が高いとしている。日本語のベンチマーク「Japanese MT-Bench」の平均スコアは5.5で、人文社会系のタスクは9.18と、米OpenAIのGPT-4よりも高い結果となった(画面1)。

画面1:Fugaku-LLMのデモ画面(出典:東京工業大学、東北大学、富士通、理化学研究所、名古屋大学、サイバーエージェント、Kotoba Technologies)

画面1:Fugaku-LLMのデモ画面(出典:東京工業大学、東北大学、富士通、理化学研究所、名古屋大学、サイバーエージェント、Kotoba Technologies)拡大画像表示

LLMのほかにも、富岳を用いてLLMの学習を効率化するためのソフトウェアも成果物として作成し、公開した。

はじめに、ディープラーニングでTransformerモデルを学習させるためのフレームワーク「Megatron-DeepSpeed」を富岳に移植し、行列演算ライブラリをCPUに合わせて最適化。この結果、最適化前には110秒かかっていた行列積の計算が18秒で済むようになり、6倍に高速化した。

ノード間通信についても、LLMの学習用途(大容量データの低頻度転送)において富岳のインターコネクト性能を最大限利用できるように、集団通信のアルゴリズムを改善し、時間あたりの転送データ量を3倍に高めた。

●Next:プログラムの深部まで国内で開発

会員登録(無料)が必要です

- 1

- 2

- 次へ >

東京工業大学 / 富岳 / 生成AI / スーパーコンピュータ / 大規模言語モデル / 理化学研究所 / 富士通 / 産学連携 / 協業・提携 / GPT / 産業技術総合研究所 / HPC / 東北大学 / サイバーエージェント / 名古屋大学 / 東京科学大学 / ABCI

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-