[ザ・プロジェクト]

次代に向けた技術基盤の“式年遷宮”─NTTドコモのビッグデータ基盤刷新プロジェクト

2024年11月28日(木)愛甲 峻(IT Leaders編集部)

データドリブン経営に邁進するNTTドコモが、ビッグデータ分析基盤を全面刷新し、データマネジメントおよびデータ活用の高度化に取り組んでいる。クラウドDWH「Snowflake」を旧基盤に代えて導入し、保守運用に要する工数・時間の削減やデータ処理の安定化を図った。データ分析にかかるコストが可視化されたことで、施策ごとのデータ活用コストと得られた効果が明確になり、ユーザーの意識改革やデータ活用レベル向上につながっているという。2024年9月に開催された「Snowflake World Tour」の事例セッションに登壇したNTTドコモのキーパーソンに、講演内容を踏まえて詳しく話を聞いた。

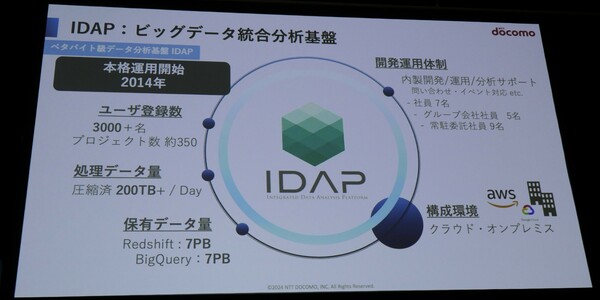

NTTドコモでは2014年より、「IDAP(Integrated Data Analytics Platform)」と呼ぶビッグデータ分析基盤を運用している(図1)。通信事業におけるネットワーク関連のデータや、金融・ヘルスケアといったスマートライフ事業のデータを格納・管理し、エンドユーザーの活用を促している。例えば、ビッグデータに基づくネットワークの品質改善や最適化などをこの基盤が支えている(関連記事:NTTドコモ、データ分析基盤にBigQueryを導入、クエリーの約7割をRedshiftからBigQueryに移行)。

1日に処理するデータは圧縮済みで200TB(テラバイト)以上、データウェアハウス(DWH)が保有するデータは実に14PB(ペタバイト)に上る。約3000名のユーザーと、約350のプロジェクトが日々利用する。

図1:IDAPの概要(出典:NTTドコモ)

図1:IDAPの概要(出典:NTTドコモ)拡大画像表示

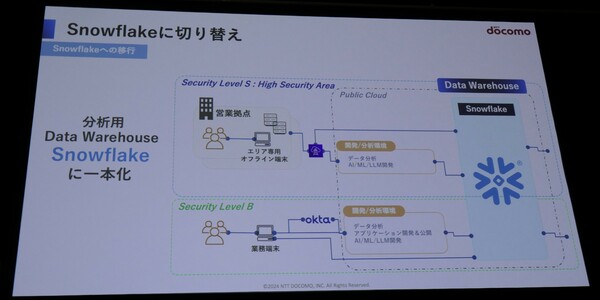

IDAPの特徴の1つは、アクセスレベルが異なる2種類のデータを扱っていることだ。ローデータに近いデータは「レベルS」とし、アクセスを同社施設内のオフライン端末に限定。一方で、統計処理されたデータは「レベルB」に分類し、社内ネットワークから業務端末によるアクセスを受け入れる。アクセス権の管理はプロジェクトごとに行っているという。

NTTドコモは、IDAPのDWHをクラウドDWHの「Snowflake」に刷新するプロジェクトに挑んだ(図2)。旧環境は「AWS Redshift」と「Google BigQuery」を併用し、オンプレミスとクラウドのハイブリッド環境で運用。しかし、データ活用が組織に広がり、IDAPで実行される分析タスクやクエリの数/種類が増加していく中、円滑なデータ活用を阻害するいくつかの問題が浮上していた。同社 R&Dイノベーション本部 サービスイノベーション部 ビッグデータ基盤担当 Principal Data Engineerの松原侑哉氏(写真1)は、直面した4つの問題を挙げた。

図2:DWHをSnowflakeに切り替えて一本化(出典:NTTドコモ)

図2:DWHをSnowflakeに切り替えて一本化(出典:NTTドコモ)拡大画像表示

写真1:NTTドコモ R&Dイノベーション本部 サービスイノベーション部 ビッグデータ基盤担当Principal Data Engineerの松原侑哉氏

写真1:NTTドコモ R&Dイノベーション本部 サービスイノベーション部 ビッグデータ基盤担当Principal Data Engineerの松原侑哉氏旧環境が抱える問題とデータ活用における課題意識

1つ目は、コストの分析に関する問題だ。NTTドコモは、RedshiftおよびBigQueryについて3年間のRI(リザーブドインスタンス)ライセンス/コミットメントを購入していた。使ったリソースにかかわらず一定のコストが発生する仕組みのため、リソースやコストをプロジェクト単位で分離することが難しい。「ユーザーの間でデータ処理の実行コストに対する意識が希薄となり、なかには非効率な処理や不要な処理が実行されていたケースもありました」(松原氏)。

2つ目は、最適な処理リソースの提供が難しかったこと。処理するデータ量の増大やアドホック/オンデマンドな処理の増加に対して、旧環境では迅速な対応が困難だったという。

3つ目は、並行して実行される処理が相互に影響し合い、実行にかかる時間が不安定だったことだ。旧環境のDWHは巨大なクラスター/スロットを構成していたが、事前に定義された有限の処理リソースである。負荷の高い処理が実行された際には、リソースを奪い合う形となり、並行する処理の実行に長い時間を要したという。

4つ目の問題である耐障害性の低さも、3つ目と同様にDWHのアーキテクチャに起因する。旧環境ではノード障害がクラスター全体の性能低下につながるため、障害発生時の影響範囲が広かったと松原氏は指摘した。

これらの問題に加えて移行を後押ししたのが、データ活用の費用対効果(ROI)に対する課題意識だ。上述のとおり、旧環境ではプロジェクトごとのデータ処理コストを算出するのが難しかったため、施策全体のROI算出においても、データ分析にかかるコストは考慮されていなかったという。

状況の打開には、処理の実行にかかる費用の透明化や安定した実行環境、最適な処理リソースのタイムリーな提供が必要となる。松原氏らはさまざまなアプローチを検討した末、Snowflakeを採用。検証から社内提供の開始まで、約1年間で移行を完了させている。

Snowflakeの特徴の1つが、データを保持するストレージと処理を実行するリソースとを分離するアーキテクチャだ。さらに実行する処理ごとに個別に計算リソースを用意できるほか、負荷に合わせた柔軟な追加・削減も可能。プロジェクトやユーザーがリソースを共有しないため、あるクエリの処理負荷が突出したとしても他の処理には影響しない。

また、Snowflakeは従量制ライセンスであり、実行した処理に応じて料金が発生する。そのため、施策単位でのデータ処理コストの透明化にも有効となる。NTTドコモ R&Dイノベーション本部 サービスイノベーション部 ビッグデータ基盤担当 担当部長の石井啓之氏(写真2)によれば、「処理とコストが対になっているので、ユーザーはより効率のよい処理を検討するようになります。その結果として、コストの最適化やデータ活用レベルの向上が実現することを見込んでいました」という狙いがあった。

写真2:NTTドコモR&Dイノベーション本部 サービスイノベーション部 ビッグデータ基盤担当 担当部長の石井啓之氏

写真2:NTTドコモR&Dイノベーション本部 サービスイノベーション部 ビッグデータ基盤担当 担当部長の石井啓之氏●Next:2種類のロールでデータアクセス権限の管理を簡素化

会員登録(無料)が必要です

- 1

- 2

- 3

- 次へ >

- データカタログ整備から広がるデータドリブン企業への変革─みんなの銀行が挑むデータマネジメント実践の軌跡(2026/01/28)

- 400万件超の商品マスターをクラウドに移行、食品流通のデジタル化を加速する情報インフラへ─ジャパン・インフォレックス(2025/12/26)

- “データ/AI Ready”な経営へ─住友電工の「グローバルデータ活用基盤」構築の軌跡(2025/12/15)

- オリンパスが挑む、医療機器ソフトウェア開発の”産業革命”(2025/10/20)

- 「データ活用宣言」を起点に広がるデータ文化─三菱電機の全社データマネジメント実践(2025/10/01)

Snowflake / NTTドコモ / データ活用基盤 / データドリブン経営 / クラウドDWH / データ統合 / BigQuery / Redshift / アナリティクス / データメッシュ / 通信事業者

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-