リコーは2025年12月8日、同社が開発・提供する日本語大規模言語モデル(LLM)の次世代モデルとして、オンプレミス環境での運用に適した270億パラメータの軽量LLMを開発したと発表した。Google Cloudのオープン版LLM「Gemma 3 27B」をベースに追加学習済みの複数のLLMを組み合わせるモデルマージ手法によって性能を強化している。モデル単体での提供のほか、GPUサーバーに搭載したアプライアンス製品を用意する。

リコーは、日本語の処理性能を強化した大規模言語モデル(LLM)「RICOH LLM」を開発・提供している。今回、次世代モデルとして、オンプレミス環境での運用に適した270億パラメータの軽量LLMを開発した。

Google Cloudのオープン版LLM「Gemma(ジェマ)3 27B」をベースに、学習済みの複数のLLMを組み合わせるモデルマージ手法によって性能を強化している。具体的には、独自開発データを含む約1万5000件のインストラクションチューニングデータで追加学習を実施し、学習で獲得した対話能力の要素をChat Vector(注1)として抽出。これら複数のChat Vectorをベースモデルにマージしている。

注1:Chat Vectorは、指示追従能力を持つモデルからベースモデルのウェイトを差し引き、指示追従能力のみを抽出したベクトルのこと。

学習済みの知識から直接回答を生成する非推論モデルとしたことで、初期応答性を高めたとしている。「執筆能力も兼ね備え、ビジネス用途での活用に適する」という。

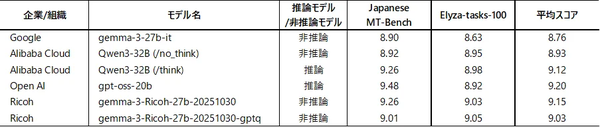

開発した日本語LLMの実際の性能について、リコーは、「ELYZA-tasks-100」ベンチマークプログラムを用いて、同規模パラメータ数のLLMとの比較を行った。その結果、米OpenAIのオープンウェイトモデル「gpt-oss-20b」などの高性能モデルと同等の性能を確認した(図1)。

図1:「ELYZA-tasks-100」ベンチマークの結果(出典:リコー)

図1:「ELYZA-tasks-100」ベンチマークの結果(出典:リコー)拡大画像表示

図2:リコージャパンが販売する、軽量な日本語LLMと生成AI開発ツールをプリインストールしたGPUサーバーの概要(出典:リコー)

図2:リコージャパンが販売する、軽量な日本語LLMと生成AI開発ツールをプリインストールしたGPUサーバーの概要(出典:リコー) モデル単体での提供に加え、2025年12月下旬から、リコージャパンがGPUサーバーに同LLMを搭載したアプライアンス製品を販売する(図2)。エフサステクノロジーズの生成AI向けサーバー「Private AI Platform on PRIMERGYに(Very Small モデル)」に、今回開発したLLMの量子化モデルと生成AI開発ツール「Dify(ディフィ)」をプリインストールして提供する。

ユーザーは、日本語LLMとDifyを活用することで、オンプレミス環境において、自社の業種・業務に必要な生成AIシステム/アプリケーションをノーコードで作成できる。また、リコージャパンは「Dify支援サービス」を提供し、社内にAIの専門人材がいない企業での生成AIの業務活用をサポートする。

リコー / 大規模言語モデル / オンプレミス / Google Cloud / GPU / リコージャパン / エフサステクノロジーズ

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-