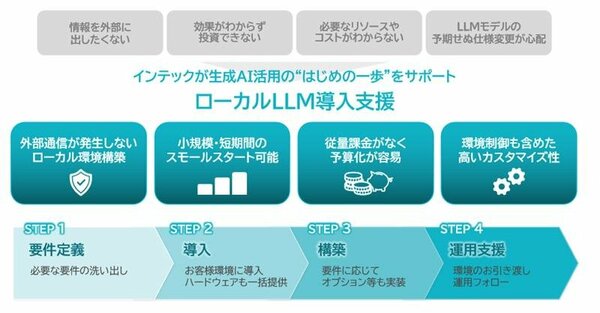

インテックは2026年1月29日、オンプレミス環境で生成AI/大規模言語モデル(LLM)を活用できる「ローカルLLM導入支援」を開始した。クラウドを介さずに稼働するLLMを最短1カ月で構築する。セキュリティやコストなどが不透明で導入に踏み切れない製造業や金融業などを対象に、機密情報を扱う業務でも安全に生成AIを利用できる環境を提供する。料金は参考価格で500万円(税別)から。

インテックは、生成AI/大規模言語モデル(LLM)をオンプレミス環境に最短1カ月で構築するSIサービスを開始した。セキュリティ懸念やコストの不透明さから生成AIの導入を躊躇している製造業や金融業などの企業に向けて提供する(図1)。外部ネットワークから遮断されたオンプレミスや閉域ネットワーク内に、専用のGPUサーバーとLLM、RAG(検索拡張生成)機能などをパッケージにしている。

図1:ローカルLLMの導入を支援するSIサービスの概要(出典:インテック)

図1:ローカルLLMの導入を支援するSIサービスの概要(出典:インテック)拡大画像表示

サービス提供の背景として、企業のDX推進において生成AIの重要性は高まっているものの、機密情報の安全性やコンプライアンスへの懸念から、実際の導入や活用が停滞するケースは少なくないことを挙げる。「一般的なクラウド型LLMは、データが外部サーバーに送信されるため情報漏洩のリスクがあるほか、提供元がモデルを管理するため自社業務に合わせた調整が難しく、従量課金制により中長期的なコスト予測が困難である」(同社)。

同サービスの特徴は、情報の外部流出リスクを極限まで低減できる点にある。一般的なクラウド型LLMは入力データが外部サーバーに送信されるが、本サービスでは自社環境内に保管された情報を参照し、外部通信なしで回答を生成する。これにより、個人情報や知的財産などの機密情報を扱う業務への適用が可能になる。

構築のステップとして、規模を限定したスモールスタート/PoCを重視している。最短1カ月という短期間で環境を構築し、実際の業務を通じた効果検証を迅速に行える。資産として保有する形態のため、中長期的な利用コストの予測が容易になるメリットもある。将来の拡張として、GPUサーバーの増設やデータセンターを含めたインフラ全体の設計・構築まで段階的にスケールアップできる。

- 業務システム 2027年4月強制適用へ待ったなし、施行迫る「新リース会計基準」対応の勘所【IT Leaders特別編集版】

- 生成AI/AIエージェント 成否のカギは「データ基盤」に─生成AI時代のデータマネジメント【IT Leaders特別編集号】

- フィジカルAI AI/ロボット─Society 5.0に向けた社会実装が広がる【DIGITAL X/IT Leaders特別編集号】

- メールセキュリティ 導入のみならず運用時の“ポリシー上げ”が肝心[DMARC導入&運用の極意]【IT Leaders特別編集号】

- ゼロトラスト戦略 ランサムウェア、AI詐欺…最新脅威に抗するデジタル免疫力を![前提のゼロトラスト、不断のサイバーハイジーン]【IT Leaders特別編集号】

-

VDIの導入コストを抑制! コストコンシャスなエンタープライズクラスの仮想デスクトップ「Parallels RAS」とは

-

AI時代の“基幹インフラ”へ──NEC・NOT A HOTEL・DeNAが語るZoomを核にしたコミュニケーション変革とAI活用法

-

加速するZoomの進化、エージェント型AIでコミュニケーションの全領域を変革─「Zoom主催リアルイベント Zoomtopia On the Road Japan」レポート

-

14年ぶりに到来したチャンスをどう活かす?企業価値向上とセキュリティ強化・運用効率化をもたらす自社だけの“ドメイン”とは

-

-

-

-

生成AIからAgentic AIへ―HCLSoftware CRO Rajiv Shesh氏に聞く、企業価値創造の課題に応える「X-D-Oフレームワーク」

-

-

-

「プラグアンドゲイン・アプローチ」がプロセス変革のゲームチェンジャー。業務プロセスの持続的な改善を後押しする「SAP Signavio」

-

BPMとプロセスマイニングで継続的なプロセス改善を行う仕組みを構築、NTTデータ イントラマートがすすめる変革のアプローチ

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-